f2020

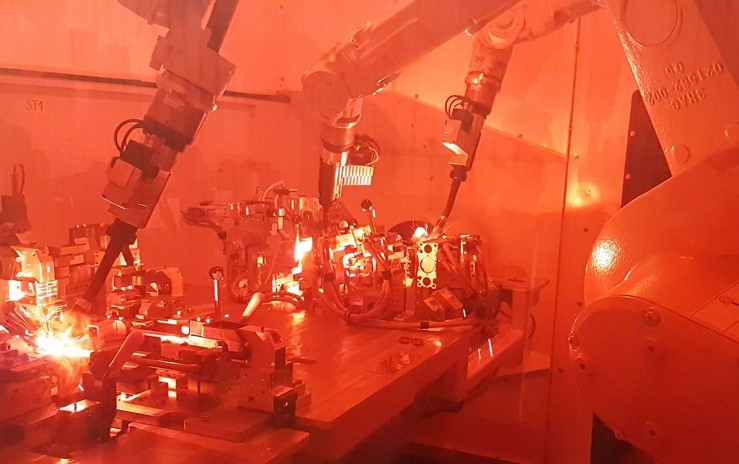

Współczesny przemysł wykorzystuje mnóstwo przeróżnych robotów do bardzo różnych zastosowań, od małych, o udźwigu np. 3 kG w wersji Hygienic Machine, stosowanych w bezpośrednim kontakcie z artykułami spożywczymi i substancjami medycznymi, do super ciężkich, handlingowych, o wadze 7 ton i udźwigu ponad 700 kG, używanych w przemyśle ciężkim do przenoszenia większych i cięższych korpusów, czy zespołów spawanych. Ich konstrukcje zależą od przeznaczenia i środowiska pracy. Budowa, a później odpowiedni dobór i wyposażenie robota, ale też jego otoczenie, muszą być dostosowane do charakteru jego pracy.

Dokonując jakiegoś pomiaru aparaturą pomiarową, urządzeniem pomiarowym lub narzędziami pomiarowymi wysokiej jakości, jesteśmy przekonani o prawdziwości i dokładności uzyskanego wyniku. Jednak w przyrodzie, w fizyce, nie ma w rzeczywistości prawdziwych i pewnych pomiarów. Pojęcie wartości rzeczywistej jest pewną abstrakcją i w zasadzie nie występuje w praktyce. Można jedynie wyznaczyć przedział, w którym wartość wyniku pomiaru się znajduje. Z wszelkimi wykonywanymi pomiarami związana jest niepewność ich wyników – niepewność pomiaru.

Aleksander Łukomski

W 1999 roku Główny Urząd Miar wydał polską wersje normy ISO: „Wyrażanie niepewności pomiaru – Przewodnik”, w której zawarto definicję niepewności pomiaru: „Niepewność pomiaru jest to parametr związany z wynikiem pomiaru, charakteryzujący rozrzut wartości, który można w uzasadniony sposób przypisać wielkości mierzonej”.

Norma ISO podaje rozróżnienie między pojęciami „niepewność pomiaru”, a „błąd” oraz podaje jednolitą terminologię i metody określania niepewności pomiaru. Dotąd słowo „błąd” miało dwa znaczenia: pierwszym z nich była nazwa dla przypadku, gdy wynik pomiaru przyjmuje wartość różną od wartości prawdziwej. Drugim znaczeniem słowa „błąd” była jego liczbowa miara.

Znaczenia te przedstawia się w postaci:

- ilościowej, będącej różnicą, także nieznaną, między wartością zmierzoną a wartością prawdziwą;

- jakościowej, która często używana jest w terminach: błąd systematyczny, błąd przypadkowy oraz błąd gruby.

W uproszczeniu, wyniki pomiarów wielkości fizycznych i chemicznych wraz z informacją ilościową o jakości pomiarów, są niepewnością pomiaru. Pozwala ona na porównanie ich z wartościami odniesienia podanymi w specyfikacjach lub normach lub do oszacowania ich wiarygodności w porównaniu z wynikami uzyskanymi przez inne laboratoria.

Niepewność jest związana z wynikami pomiarów i badań. Wyniki pomiarów pozbawione oceny ich dokładności są w zasadzie tylko wskazaniami.

Podając wyniki pomiarów wielkości fizycznych powinno się podawać również informację ilościową o dokładności tych pomiarów. Jest to konieczne dla tego, kto wykorzystuje te pomiary w swojej pracy, po to aby oszacować ich wiarygodność. Bez tej informacji wyniki pomiarów nie mogą być porównywane ze sobą, ani z wartościami odniesienia podawanymi w specyfikacjach lub normach.

cały artykuł dostępny jest w wydaniu płatnym listopad/grudzień 11/12 (158/159) 2020

Żyjemy w dobie globalizacji, poszukiwania sposobów na optymalizację wyników finansowych, czy też zaspokojenie specyficznych wymagań niektórych rynków. Zarówno duże koncerny, jak i mniejsze firmy otwierają biura, nawiązują współpracę w krajach o niższych kosztach produkcji, bądź zlokalizowanych bliżej klienta końcowego. Państwa takie jak Arabia Saudyjska czy Zjednoczone Emiraty Arabskie wręcz wymagają od potencjalnego kontrahenta posiadania biura na ich terenie oraz zaangażowania lokalnych firm.

Rafał Cop

W wyniku opisanych powyżej czynników coraz częściej elementy systemu sterowania (np. szafy sterownicze, rozdzielnice niskiego i średniego napięcia) wykonywane są w kilku, często bardzo oddalonych od siebie miejscach. Utrudnia to proces testowania oraz zaprezentowanie i odbiór systemu przez klienta, w ramach tzw. FAT (Factory Acceptance Test). W wyniku opisanych powyżej czynników coraz częściej elementy systemu sterowania (np. szafy sterownicze, rozdzielnice niskiego i średniego napięcia) wykonywane są w kilku, często bardzo oddalonych od siebie miejscach. Utrudnia to proces testowania oraz zaprezentowanie i odbiór systemu przez klienta, w ramach tzw. FAT (Factory Acceptance Test). Co zrobić w sytuacji, gdy dostępna jest tylko główna cześć systemu (sterowniki PLC lub DCS i wizualizacja HMI lub SCADA)? Jako profesjonaliści nie załamujemy rąk, lecz działamy.

Opcji jest kilka, choć nie zawsze możliwe jest zastosowanie każdej z nich:

- przepisać wyjścia na wejścia, wplatając pomiędzy jakieś proste symulacje w głównym programie sterownika,

- przygotować symulacje sprzętowe, wykorzystując przełączniki, potencjometry, przekaźniki, lampki itp.,

- zastosować symulację przy użyciu innego sterownika,

- użyć dedykowanego środowiska symulacyjnego: Hardware in the Loop (HiL) lub Software in the Loop (SiL).

Opcja pierwsza czasem wystarcza, ale ingerujemy wtedy w docelowy program i możemy zapomnieć usunąć wprowadzone modyfikacje. W niektórych branżach (np. w farmaceutyce) kolejne wersje programu są bardzo restrykcyjnie kontrolowane i przechowywane. Wszelkie odstępstwa muszą być odnotowane, co utrudnia użycie tego sposobu.Opcja druga jest całkiem niezła, bowiem za pomocą przełączników możemy symulować wejścia cyfrowe, a za pomocą potencjometrów – wejścia analogowe. Stan wyjść można zobrazować przy pomocy lampek lub innych indykatorów.

Rys. 1 Konfiguracja sprzętu

Pewną automatyzację testowania daje przygotowanie mniej lub bardziej skomplikowanej logiki na przekaźnikach. Opcja ta nie wystarcza jednak, gdy chcemy w sposób w miarę wierny symulować zachowania w czasie rzeczywistym. Chyba, że mamy na podorędziu większą grupę osób, która niczym orkiestra pod batutą dyrygenta będzie odtwarzać symulacyjną symfonię…

cały artykuł dostępny jest w wydaniu płatnym listopad/grudzień 11/12 (158/159) 2020

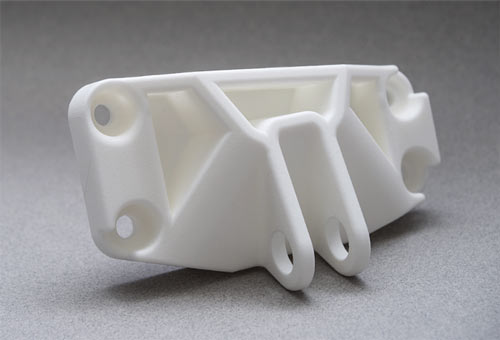

Metoda selektywnego spiekania laserowego to jedna z najpopularniejszych technik wytwarzania przyrostowego, dominująca w dziedzinie druku 3D z materiałów polimerowych do zastosowań profesjonalnych. Rosnące wymagania użytkowników, a także konkurencja w tak szybko rozwijającym się sektorze przemysłu, wymagają poszukiwania innowacyjnych rozwiązań, zwiększających potencjał techniki SLS w zakresie wytwarzania wyrobów o walorach nie tylko estetycznych, ale i coraz częściej w pełni użytkowych.

Jacek Zbierski

Technologia SLS opiera się na wykorzystaniu lasera do rzutowania przekroju drukowanego wyrobu na powierzchnię platformy roboczej pokrytej pojedynczą warstwą proszku w atmosferze gazu ochronnego. Energia wiązki lasera selektywnie konsoliduje drobiny proszku w obszarze wydruku, pozostawiając otaczający proszek w stanie niespieczonym. Następnie rolka powlekająca nanosi kolejną warstwę proszku i sekwencja zostaje powtórzona, aż do uzyskania kompletnego wyrobu, na który po wystygnięciu czeka jeszcze kolejny etap, związany z separacją wyrobu od pozostałego proszku. Głównymi czynnikami o decydującym wpływie na przebieg procesu technologicznego są tu właściwości surowca w postaci proszku, parametry źródła energii – lasera oraz wzajemne oddziaływanie tych czynników. Tak więc sam proces nie sprawia wrażenia szczególnie skomplikowanego, jednak u jego podstaw występuje cały szereg złożonych problemów, których przezwyciężenie wydaje się być kluczem do dalszego doskonalenia technologii SLS.

Innowacyjne kompozycje proszkowe

Surowiec w postaci granulatu, przygotowany pod kątem druku 3D w technologii SLS, musi spełniać odpowiednie kryteria w celu zapewnienia optymalnych parametrów spiekania. W tym kontekście bierze się pod uwagę takie właściwości proszków jak sypkość, upakowanie cząstek, ich wielkość oraz kształt, a także charakterystyki termiczne i reologiczne materiałów. Najbardziej rozpowszechnionymi materiałami do procesu SLS są poliamidy PA11 i – przede wszystkim – PA12, zajmujący 90% rynku proszków do SLS. Zasadniczo granulat PA11 otrzymywany jest w procesie mielenia kriogenicznego, a drobiny PA12 wytrąca się z roztworu polimerowego w ramach termicznie indukowanej separacji faz – TIPS (thermal induced phase separation). Tak otrzymane cząstki zapewniają optymalne, równomierne zagęszczenie surowca w przestrzeni roboczej drukarki, na której dają się z łatwością rozprowadzać, a także pozwalają uzyskać odpowiednią grubość warstw, która przekłada się bezpośrednio na rozdzielczość wydruku.

cały artykuł dostępny jest w wydaniu płatnym listopad/grudzień 11/12 (158/159) 2020

Elastomery silikonowe są materiałami o unikalnych własnościach użytkowych (m.in. odporność termiczna czy obojętność fizjologiczna). Na rynku znane są jako silikony stałe i ciekłe. Znajdują zastosowania w technice, medycynie oraz w wyrobach codziennego użytku. Innym ich atutem w porównaniu do kauczuków wulkanizowanych jest stosunkowo łatwe i ekonomiczne przetwórstwo metodą wtrysku oraz prasowania (dot. silikonów stałych), mimo że technologia wtrysku często wymaga zwiększonych nakładów finansowych i stawia wysokie wymagania technologiczne. Podobnie jak inne elastomery, silikony (zwłaszcza ciekłe) wykazują dużą adhezję powierzchniową, co pozwala na rozszerzenie zastosowań o techniki obtrysku zaprasek metalowych oraz wtrysku wielokomponentowego.

Andrzej Zwierzyński

Podstawowym pierwiastkiem w chemii silikonów jest krzem (Si). Naturalnie występuje jako dwutlenek krzemu SiO2 (znany jako kwarc lub krzemionka) i stanowi ok. 25,8% całkowitej masy skorupy ziemskiej. Technologia oparta na bazie krzemu miała swoje początki już w czasach starożytnych (około 3500 lat temu ludzie umieli już zamieniać piasek w szkło). W 1904 r. angielski chemik Frederich Kipping nadał materiałowi nazwę „silikon”.

Początkowo silikony zostały uznane za nieprzydatne i dopiero po przeprowadzeniu dokładniejszych badań zostały właściwie ocenione. Produkcję przemysłową elastomerów silikonowych uruchomiono pod koniec lat 40-tych. W 1969 r. Neil Armstrong użył butów z silikonowymi podeszwami podczas pierwszego spaceru po księżycu. Z kolei w roku 1970 opracowano ciekły kauczuk silikonowy. Ważną rolę odegrały silikony w latach 80-tych w rozwoju technologii mikroprocesorowych, chroniąc produkty przed przegrzaniem.

Na początku lat 90-tych powstały pierwsze soczewki kontaktowe wykonane z hydrożelu silikonowego.

Silikony od wielu lat cieszą się dużym zainteresowaniem na rynku. Wynika to z ich unikalnych własności użytkowych, pozwalających na skuteczne zastępowanie kauczuków wulkanizowanych w zastosowaniach technicznych, medycynie, a także w wyrobach codziennego użytku.

Oba rodzaje silikonów można przetwarzać metodą wtrysku. Silikony stałe HTV (High Trmperature Vulcanizing), określane też HCR (High Consistency Rubber), przetwarza się częściej poprzez prasowanie, ale możliwy jest też tradycyjny wtrysk, jak kauczuków wulkanizowanych. Natomiast wtrysk ciekłych silikonów LSR (Liquid Silicone Rubber) wymaga specjalnego wyposażenia wtryskarek i dodatkowych peryferiów. Stawia też wysokie wymagania technologiczne oraz wymusza dodatkowe nakłady finansowe, dlatego jest opłacalna dopiero przy długich seriach. Technologia wtrysku ciekłych silikonów jest też nazywana LIM (Liquid Injection Molding Elastomer).

Podobnie jak inne elastomery, silikony (zwłaszcza ciekłe) wykazują dużą adhezję powierzchniową, a zatem zdolność łączenia z innymi materiałami (metalami, termoplastami), co pozwala rozszerzyć zastosowania o techniki obtrysku zaprasek metalowych oraz wtrysk wielokomponentowy.

cały artykuł dostępny jest w wydaniu płatnym październik 10 (157) 2020

Specjalistyczny portal inżynierski dla osób zaangażowanych w tworzenie produktów – maszyn, urządzeń, mechanizmów, podzespołów, części, elementów itd. – od koncepcji do ostatecznego wykonania.