Wybór redakcji 2014

Wiktor Schauberger jest postacią tajemniczą, która często powraca w dyskusjach o latających spodkach i tzw. wolnej energii. Chyba nikt nie spodziewał się, że zjawiska, które zgłębiał wykorzystywane będą w 2014 roku i to w tak konkurencyjnej i bezwzględnej dziedzinie, jak konstruowanie samochodów wyścigowych Formuły 1. Po raz kolejny osiągnięcia Schaubergera trafiły do biur projektowych, których prace objęte są tajemnicą.

Ryszard Romanowski

Schauberger urodził się na terenach monarchii Austro-Węgierskiej w leżącym na terytorium Austrii miasteczku Schwarzenberg am Böhmerwald 30 czerwca 1885 roku. Ojciec, który pracował jako drwal w okolicznych lasach, oswajał syna z potęgą przyrody. Młody Wiktor z wielkim zainteresowaniem obserwował życie lasu i bacznie je analizował.

Wiktor Schauberger

Szczególnie fascynowały go strumienie i zjawiska rządzące prądem wody. Zastanawiał się nad kamieniami na dnie górskich zatoczek, które omijał rwący nurt potoków. Nikt nie mógł mu wyjaśnić dlaczego niektóre unoszą się aż do powierzchni, a po chwili pomału opadają na dno. Podobnych obserwacji miał znacznie więcej. Mimo, że pochodził z niezamożnej rodziny, postanowił rozpocząć studia na wydziale leśnym, licząc, że tam znajdzie odpowiedzi na nurtujące go od lat pytania. Niestety, lata I wojny światowej nie sprzyjały zgłębianiu zjawisk przyrody. Trzeba było koncentrować się na utrzymaniu rodziny.

Wbrew obowiązującym ustaleniom naukowym

Po wojnie książę Adolf Schaumburg Lippe zaproponował mu posadę nadleśniczego. Nie było mowy o dalszym studiowaniu ale nadal mógł obcować z przyrodą i zajmować się hydrologią. Wtedy już stał się osobą znaną w środowisku. Potrafił tak zmodernizować wąskie górskie strumyki, że nadawały się do spławiania drewna.

Transport drewna

Jego konstrukcje związane z regulacją i tworzeniem nowych tzw. dzikich strumyków oszczędzały pieniądze, wysiłek i zdrowie drwali. Belki spływały ze szczytów w niemal cudowny sposób i metoda szybko zaczęła zdobywać popularność, oraz doczekała się patentu. Schauberger słynął również z dyskusji z naukowcami, w których często podważał obowiązujące prawa fizyki.

Transport drewna

Znana jest jego wypowiedź na temat obserwacji poczynionych przez Izaaka Newtona: żałuję, że nie zwróciłem uwagi na to, jak jabłko spadało w dół, ale też jak urosła jabłoń podnosząc je do góry – mawiał. Nie zadowolił się również patentem na spławianie drewna, który zaczął przynosić zyski. Pragnął znaleźć odpowiedź na pytania dotyczące zjawisk nieznanych w środowiskach naukowych lub przez nie ignorowanych. Wierzył, że wykorzystując energię wody i powietrza będzie można konstruować nawet maszyny latające, znacznie tańsze i sprawniejsze od istniejących. Żyjąc w niesprzyjających czasach nie ustawał w eksperymentach. Mimo że jego dokonania wykorzystywano praktycznie, oficjalna nauka zupełnie go ignorowała. Schaubergera fascynowało zjawisko implozji. W przeciwieństwie do wykorzystywanego, chociażby do napędu turbin, wysokiego ciśnienia wody, poszukiwał energii w strefach obniżonego ciśnienia.

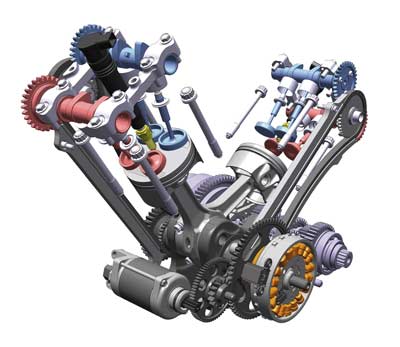

Turbina wodna

Rozpatrywał samopodtrzymujący się ruch wirowy przepływu cieczy lub gazu, odbywający się w sposób uporządkowany oraz towarzyszące mu obniżenie temperatury substancji. Wykorzystywał również znane i stosowane przez konstruktorów lotniczych zjawisko Coandy. Jego teorię potwierdzały maszyny budowane od stuleci przez rzemieślników, dla których obowiązujące ustalenia naukowe w dziedzinie fizyki były czymś mało znanym. W napędzanych wodą młynach i młotach kowalskich znacznie częściej wykorzystywano swobodny przepływ wody niż ciśnienie powodowane jej spiętrzeniem.

Efektem dociekań była specjalna konstrukcja rury mająca na celu zwiększenie prędkości przepływu wody. Stożkowata i użebrowana konstrukcja nie tylko przyśpieszała ruch wody powodując jej silne zawirowanie ale powodowała obniżenie jej temperatury i zwiększenie gęstości przepływu. Jednocześnie opracował turbinę znajdującą się w centrum reaktywnego strumienia wody. Turbina przypominająca nieco stożkowaty korkociąg lub spiralną kotwę dostosowana była do wysokich obrotów, a jednocześnie pozbawiona zjawisk związanych z kawitacją. Rura Schaubergera z cykloidalną spiralą wewnątrz została dokładnie przebadana i okazało się, że przy pewnych prędkościach przepływu jej opór hydrodynamiczny staje się zerowy, a nawet ujemny. Oznacza to, że urządzenie potrafi przyśpieszyć przepływ. Można było w nim również obserwować powstawanie podwójnego, wirującego strumienia cieczy. Na dzieleniu strumieni cieczy lub gazu polega działanie większości urządzeń Schaubergera. Zauważył on, że procesy takie są powszechne w przyrodzie i przy określonej formie wiru, jego prędkości i temperaturze, ruch staje się samonapędzający i może służyć za źródło energii. Przykładem są trąby powietrzne.

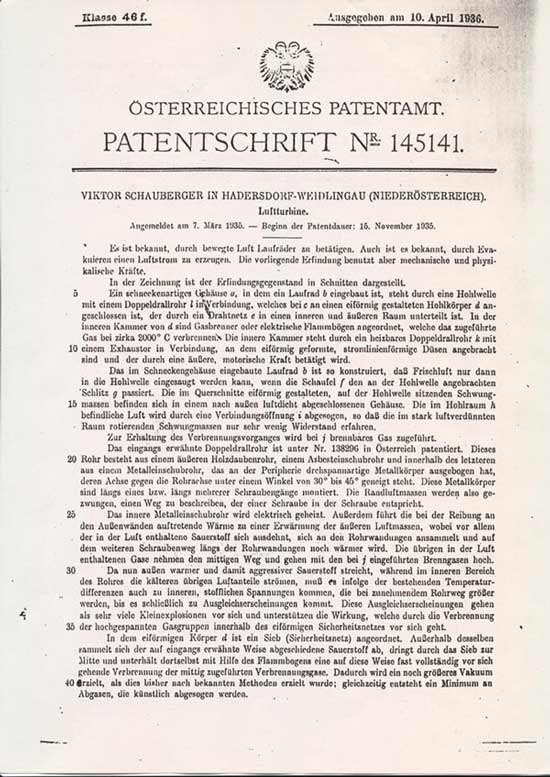

Turbina powietrzna

W ich przypadku dolna część jest naładowana ujemnie, a górna dodatnio. Powstają one w określonych, trudnych do osiągnięcia w sposób sztuczny warunkach. Odbywa się w nich przemiana energii rozproszonej w lokalną i można je nazwać naturalnymi silnikami – generatorami. Badania zaowocowały patentami, lecz nie wzbudziły zainteresowania ówczesnego środowiska naukowego. Zarówno inercja oficjalnej nauki, jak i trudne materialnie lata powojenne nie sprzyjały tego rodzaju odkryciom.

Repulsin i latające spodki

Wynalazca zapewne nie zdawał sobie sprawy, że rodzi się system, który poszukuje zarówno naukowców, jak i szarlatanów, aby stworzyć urządzenia techniczne mające zapewnić mu panowanie nad światem. Specjalne służby III Rzeszy wnikliwie przeglądały literaturę naukową i patenty. Książkę Schaubergera wydaną w Wiedniu dostarczono do rąk samego wodza. Hitler zaprosił austriackiego wynalazcę i zaproponował mu pieniądze na kontynuowanie badań. Prace rozpoczęły się 1938 roku i wiadomo o nich niewiele.

Nieliczni świadkowie twierdzą, że widzieli modele wzbijające się wysoko w niebo i swobodnie manewrujące. Znane są urządzenia przypominające latające spodki budowane w zakładach Skody. Eksperymenty musiały być obiecujące bo weszły w skład Entwicklungsstelle IV, za którą odpowiadał sam Himmler.

Warto dodać, że grupa ta pracowała również nad latającymi dyskami Vril i nad napędem Thule, o czym Austriak być może nie wiedział. Wspominał, że nie miał wtedy wyboru bo dostał tzw. ofertę nie do odrzucenia. Jego laboratorium mieściło się w Rosenhugel. Nie bardzo wiadomo co tam budowano. Świadkowie potwierdzają, że widzieli coś w rodzaju latających spodków. Wiadomo również, że projekt samolotu z niekonwencjonalnym silnikiem odrzutowym Repulsin Schaubergera zakupiła firma Heinkel.

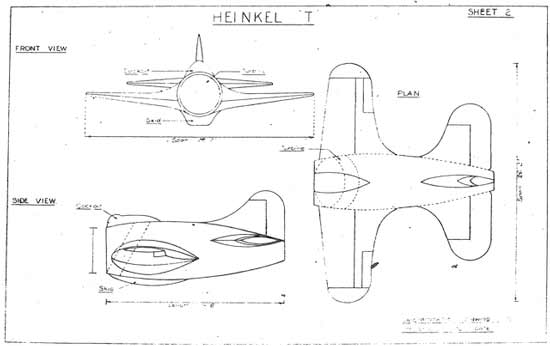

Plany Heinkla z silnikiem Repulsin

Można mieć pewność, że inżynierowie tak doświadczonej firmy nie wydawaliby pieniędzy na coś z pogranicza szarlatanerii. Przed opracowaniem samolotu wynalazca nie ukrywał twierdzenia, że jego zdaniem rozwój lotnictwa hamuje konstrukcja śmigła.

Wiadomo, że wywiad aliancki również coś wiedział o eksperymentach, bo przeprowadzono nalot i ośrodek badawczy przestał istnieć. To co z niego zostało przeniesiono do miasteczka Leonstein, a braki kadrowe uzupełniono więźniami z pobliskiego obozu koncentracyjnego. Niebawem do tego miejsca dotarli amerykańscy żołnierze.

Być może tam natrafili na jeden z prototypów urządzenia zwanego bączkiem Schaubergera. Urządzenie to wznosiło się w powietrze wydzielając przy tym wokół siebie poświatę. Nie było śladów wersji załogowych. Może trafili na działający Repulsin?

Repulsin – schemat przepływu strumieni powieterza

Domowy generator

Pracami Schaubergera interesowali się zarówno Rosjanie, jak i Amerykanie. Jednak on sam nie był poszukiwany żadnym listem gończym. Po wojnie współpracował z kilkoma firmami i był znany w austriackim środowisku naukowym. Ten okres jego życia jest również bardzo tajemniczy. Wiadomo, że dopiero w 1958 roku, w wieku 73 lat, wyjechał do USA. Towarzyszył mu syn Walter. Nie wiadomo czy wcześniej współpracował z Amerykanami.

Z dokumentacji patentowej domowego generatora W. Schaubergera

Ostatnim jego wynalazkiem był domowy generator. Urządzenie mające zapewnić energię gospodarstwom domowym jest równie tajemnicze, jak wcześniejsze wynalazki. Prace nad nim trwały na długo przed wyjazdem do Ameryki. Być może wynalazca miał dosyć pracy na rzecz wojska? W każdym razie prototyp maszyny został skonfiskowany... za długi.

Schauberger niedługo cieszył się pobytem w Ameryce. Zmarł w 1958 roku. Zbudowanych po jego śmierci generatorów nie udało się uruchomić. Jego syn Walter uczestniczył później w budowie prototypu implozyjnej turbiny wodnej Leopolda Scheriau’a, bardzo zbliżonej do domowego generatora.

Wiktor Schauberger przy swoim generatorze

Urządzenie działało w następujący mniej więcej sposób: przy zamkniętym głównym zaworze wpływała do turbiny woda, napełniając urządzenie. Po otwarciu zaworu ssącego powietrza silnik elektryczny rozkręcał wirnik. Zasysane spiralnymi rurami powietrze przechodziło przez górny zawór do zbiornika z wodą. Nadciśnienie zamykało zawór powietrzny i otwierało zawór doprowadzający wodę. Podczas zamykania zaworu powietrza w rurach spiralnych i zasilających górny zbiornik powstawała próżnia. Woda podnosiła się do górnego zbiornika, a następnie pod dużym ciśnieniem podążała do wtryskiwaczy, dostając się na łopatki wirnika i wprawiając go w ruch. W urządzeniu brakowało czegoś, o czym wiedział Schauberger. Złośliwi twierdzili, że Scheriau’owi chodziło wyłącznie o prawa patentowe.

Patent generatora W. Schaubergera

Pozostały patenty i wiele teorii, często spiskowych. Mówi się, że naukowiec już krótko po wojnie rozpoczął współpracę ze służbami USA i dziwne zjawiska nad Roswell są efektami jego prac. Teorie te są podsycane przez dowody na istnienie tzw. bączków w tajnych zakładach III Rzeszy. Pracami austriackiego naukowca zainteresowali się również różni „uzdrowiciele” uzasadniając swoje teorię tzw. żywej wody. Okazało się również, że znajomość jego osiągnięć może pomóc w walce konkurencyjnej na torach Formuły 1, podnosząc efekty podciśnienia lub docisku aut wyścigowych. Wiele teorii Austriaka potwierdziła współczesna nauka, a jego konstrukcje ciągle zadziwiają i inspirują.

Ryszard Romanowski

artykuł pochodzi z wydania 12 (87) grudzień 2014

Klejenie, jak każda technologia, ma swoje ograniczenia i wymagania. Nie można więc przekładać wprost rozumowania stosowanego przy innych technologiach.

Marek Bernaciak

Podstawą jest zrozumienie, że klejenie preferuje pewne kierunki i rodzaje obciążeń, a innych nie lubi. Omówmy je pokrótce.

Rodzaje naprężeń działających na złącza klejone wraz z oceną sposobu kształtowania złącza i rodzajami zalecanych klejów

Do opisu każdego rodzaju naprężeń dołączam poglądowy rysunek złącza z zaznaczonymi kierunkami naprężeń.

Ścinanie

Kleje generalnie je uwielbiają. Właśnie dlatego klej dobrze trzyma na dużej powierzchni. Jeśli tylko można, należy zaplanować tzw. zakładkę.

Rys. 1 Ścinanie

Ściskanie

Znowu bingo! Powierzchnia styku dwóch podłoży nigdy nie jest doskonale płaska. Jeśli położymy deskę na betonie albo nawet metalową płytę (na przykład podstawę maszyny) na innej metalowej płycie, te powierzchnie nie stykają się całe, stykają się tylko wierzchołki ich chropowatości. Dlatego częstym zjawiskiem jest wygniatanie się podłoża, zwłaszcza gdy jeden substrat jest znacznie twardszy od drugiego.

Klej wypełnia przestrzenie między wierzchołkami chropowatości i rozkłada siły nacisku na większej powierzchni. Dlatego na przykład klei się złącza szyn kolejowych razem ze skręcaniem śrubami. Posadawia się także maszyny na żywicach. Chociaż to inna historia.

Kleje do zastosowania: twarde, wytrzymałe i lejne, jak epoksydy lub dwuskładnikowe poliuretany. Nie za grubo, ale tyle, żeby wszystkie szczeliny były zapełnione, żeby element górny pływał na kleju w czasie łączenia.

Rys. 2 Ściskanie

Rozciąganie

Klej ma w takim wypadku zwykle znacznie mniejszą wytrzymałość niż materiał rodzimy. Krótko mówiąc, sklejone tworzywo sztuczne poddane obciążeniom rozciągającym pęknie na złączu klejonym.

Co zrobić? Zmienić obciążenie na ścinające, czyli zastosować zakładkę.

Kleje do zastosowania: elastyczne, kompensujące nierówne rozkłady naprężeń, na przykład silikony, polimery MS, elastyczne poliuretany. Nakładaj grubo, zostaw minimum 1-milimetrową szczelinę, grubsza niż 4 mm też nie zawadzi. Raczej nie będziesz żałował.

Rys. 3 Rozciąganie

Rozłupywanie

Niebezpiecznie… kleje nie lubią skupionych obciążeń. Dlatego jeśli chcesz zniszczyć połączenie klejone, zastosuj klin i włóż coś cienkiego, ostrego i staraj się rozłupać. Znasz to na pewno z praktyki, jeśli chcemy odkleić okleinę od drewnianej powierzchni, należy ją podważyć nożem. Delikatnie, ale i tak złącze zacznie się rozwarstwiać.

Kleje do zastosowania: o dobrej adhezji, ale elastyczne. Idealne w większości wydają mi się polimery MS albo poliuretany z dobrze dobranym podkładem (primerem). Elastyczne kleje są w takich sytuacjach mocniejsze niż mocne, sztywne kleje, na przykład epoksydowe. Dzieje się tak dlatego, że naprężenia rozkładają się na większej objętości. Nie dochodzi wtedy do ich skupienia w małych, często nawet nie liniowych, ale punktowych miejscach zapalnych, jakimi są krawędzie na styku kleju i materiału rodzimego.

Rys. 4 Rozłupywanie

Oddzieranie

Nie, nie, nie… nigdy tak nie projektuj! Klejenie nie lubi obciążeń skupionych (pamiętasz, przed chwilą o tym mówiliśmy). Aby zniszczyć połączenie klejone, można dodatkowo naciąć podłoże elastyczne i oddzierać je paskami. Tak można odrywać na przykład paski sztucznej skóry (wykonanej z PCV) od sztywnego podłoża. By zamienić kierunek obciążeń, zrób chociażby tak, jak na rysunku 6. Widzisz, da się.

Jak w takim razie projektować prawidłowe połączenia klejone na tworzywach sztucznych? Przyjrzyjmy się kilku przykładom.

Rys. 5 Odzieranie

Rys. 6 Projekt alternatywny dla pokazanego na rysunku 5

Zalecane sposoby rozkładania naprężeń przy złączach klejonych

Do każdego opisu typu złącza dołączam poglądowy rysunek złącza z widoczną spoiną klejową.

Ekran

Ten kształt złącza pozwala na zachowanie szczelności i estetyki. Dodatkowo można potraktować wypływkę kleju jako narzędzie kontroli jakości. Jeśli jest równomierna, może nawet spełniać rolę ozdobną.

Złącze jest relatywnie łatwe do wykonania przy zastosowaniu prostych urządzeń dozujących, wypływkę w produkcji jednostkowej łatwo wytrzeć lub schować pod maskowaniem.

Złącze jest odporne na odrywanie, w zasadzie jest poddane obciążeniom ściskającym. Często stosowane w obudowach i pokrywach urządzeń elektrycznych, jak na przykład smartfony, tablety itp.

Rys. 7 Ekran

Nakładka lub pokrywa

To nie jest wbrew pozorom kiepski pomysł. Złącze poddaje się tu ścinaniu i rozciąganiu, zwykle o niskich wartościach. Z technologicznego punktu widzenia łatwo je też wykonać. No i nie widać go z góry.

Rys. 8 Nakładka lub pokrywa

Nakładka wzmocniona

Powierzchnia kleju jest większa, czyli złącze widocznie mocniejsze. Utrudnienie stanowi wykonanie dolnych elementów, które może podnosić koszt złącza.

Rys. 9 Nakładka wzmocniona

Szyba

Takie złącze stosuje się często przy wklejaniu szyb i wzierników w szafach rozdzielczych, nie przeszkadza tu lekko widoczna spoina klejowa.

Rys. 10 Szyba

Tuleja, pióro-wpust

Typowe dla stolarstwa i… łączenia wałków metalowych za pomocą klejenia.

Takie połączenie jest idealne dla większości połączeń, ma wiele modyfikacji, jak choćby ta pokazana na rysunku.

Proporcje trzeba oczywiście obliczyć i sprawdzić na modelach.

Rys. 11 Tuleja, pióro-wpust

Nie trzeba dalej rozwijać tematyki kształtowania złącza. Wystarczy, że sam poeksperymentujesz i porozcinasz coraz częściej pojawiające się konstrukcje klejone, żeby zobaczyć, jak są ukształtowane.

Wady przetwórstwa

Kleje wymagają utwardzenia. Wróćmy na chwilę do teoretycznych podstaw, nie unikniemy tego właśnie tutaj: klej jest płynem. Dla mnie osobiście zawsze jest płynem, nawet jeśli jest to zestalony płyn w granulacie, który trzeba roztopić przed nałożeniem. I po nałożeniu trzeba elementy ustalić. Nie docisnąć, a właśnie ustalić. I poddać procesowi utwardzania. Jakiemu – o tym napiszę przy okazji omawiania różnych rodzajów klejów. Jednak zawsze jest to proces, który należy przeprowadzić w kontrolowanych warunkach. Obojętnie, czy chodzi o poddanie kleju promieniowaniu UV, czy zostawienie dwuskładnikowego kleju do utwardzenia w piecu termicznym, a nawet zatrzymanie wyrobu na polu odkładczym w temperaturze otoczenia.

UWAGA: Wszystkie uwagi dotyczące doboru klejów potraktuj jako zaledwie orientacyjne. To mogą być dobre wskazania dla początkujących. Jednak każdy przypadek należy potraktować i rozważyć osobno.

Wdrożenie i prowadzenie procesu technologicznego dla każdego rodzaju kleju wymaga pełnego zrozumienia jego charakteru i rygorystycznego stosowania opracowanych w laboratorium aplikacyjnym procedur. I tych procedur nie wolno zmieniać bez powtórnego przeprowadzenia całego zestawu badań, które przeprowadzono wcześniej, kwalifikując i walidując proces do wdrożenia.

Obliczenia wytrzymałości połączeń klejonych

Wiele osób chciałoby wiedzieć, jak precyzyjnie obliczać wytrzymałość połączeń klejonych. Wiele doktoratów na ten temat napisano, jak to w państwowych systemach szkolnictwa, ale nic z nich nie wynika dla późniejszych zastosowań w technice (naukowcy się na mnie obrażą, jednak wielokrotnie otrzymywałem pytania od studentów, by dać im „materiały do pracy dyplomowej”.

Obraz, jaki się z tych rozmów wyłania, jest co najmniej pesymistyczny). Warto wiedzieć, że podstawowe sposoby prowadzenia obliczeń wytrzymałościowych, wychodzące z laboratoryjnych danych na temat wytrzymałości na ścinanie, rozciąganie, ściskanie, nie sprawdzają się w rzeczywistych konstrukcjach. Rozbieżności pomiędzy wynikiem obliczeń a wartościami osiąganymi w badaniach niszczących są tak duże, że spokojnie można potraktować podstawowe obliczenia jako co najwyżej orientacyjne. Podchodząc praktycznie do zagadnienia wytrzymałości złącza klejonego, możemy przyjąć kilka strategii.

1. „Na oko” – czasem złącze klejone nie przenosi wielkich obciążeń. Jednak nie zawsze musi to być słaby punkt konstrukcji. Najczęściej złącze klejone jest najsilniejszym punktem konstrukcji, zwłaszcza jeśli klej został dobrze dobrany, a złącze prawidłowo zaprojektowane tylko pod względem kształtu, bez specjalnych wyliczeń.

2. „Techniczna” – czasem trzeba zaprojektować kosztowny albo wrażliwy na koszt element klejony i zoptymalizować złącze klejone pod względem konstrukcji. Wtedy może opłaci się skorzystać z oprogramowania symulującego rozkład naprężeń, na przykład metody elementów skończonych. Symulacja komputerowa to właściwie jedyny sposób obliczeń dający sensowne wyniki. Ponieważ jest kosztowny i pracochłonny, stosuje się go tylko w naprawdę odpowiedzialnych konstrukcjach.

3. „Pal – popraw – pal” – czyli zrób złącze, sprawdź na modelu, rzuć kilka razy… popraw, odchudź… pogrub… Niby prymitywna i praktycystyczna metoda, ale w dzisiejszych czasach, gdy w kilka godzin można wydrukować tani model 3D, takie podejście jest całkiem sensowne kosztowo i czasowo.

Krótko mówiąc, trzeba zacząć i działać. Podjąć próby i zdobyć własne doświadczenie. To jest prawdziwa wartość w świecie hipokryzji, ideologii i ignorancji. W tym miejscu mówię o ignorancji dotyczącej procesów klejenia oczywiście. Ciągle jest miejsce na rynku, by wykorzystać zalety technologii klejenia i związanego z nią doświadczenia.

Muszę tu dodać kilka słów teorii. Rozmawiając o klejeniu, należy odróżnić adhezję od kohezji.

UWAGA: Model z drukarki 3D nie jest wykonany z tego samego materiału, z którego będziesz produkował! Musisz to uwzględnić w procesie projektowania procesu. Niemniej jednak, po pewnej liczbie doświadczeń z modelem i wykonaniu kilku testów klejenia na ka-wałkach rzeczywistego tworzywa sztucznego i dobranego do niego kleju, można dość dokładnie oszacować szanse na sukces.

Adhezja to siła łącząca klej z podłożem. Kohezja to wewnętrzna spójność kleju, ale także materiału rodzimego. Jest to ważne przy ocenie zerwania złącza klejonego. Jeśli po zerwaniu złącza widzimy klej na obu łączonych powierzchniach, określamy zerwanie jako kohezyjne, bo pękł sam klej i możemy uznać, że jakość klejenia była właściwa od strony technologicznej. Nie jest to jednak do końca profesjonalna ocena. Często bowiem silny klej, zwłaszcza sztywny, odrywa się właśnie adhezyjnie. I nie ma w tym nic złego. Ważne są siły i warunki, w jakich nastąpiło zerwanie. Zagadnieniem spornym jest ocena, na ile w zniszczonym złączu przyczyną zerwania był niewłaściwy dobór kleju, a na ile niewłaściwie wykonany (lub dobrany) proces klejenia, a zwłaszcza przygotowania powierzchni. Chroniąc się przed zarzutem niedbalstwa, producenci częściej dobierają kleje o niższej kohezji, by zerwanie było właśnie kohezyjne.

Klejenie to proces technologiczny!

Niezależnie, czy stosujesz klej w domu do naprawy pękniętych kafelków, czy wdrażasz wklejanie wziernika do pokrywy w obudowie szafy elektrycznej, nie banalizuj tego, co robisz. Chyba że w ogóle nie zależy ci na tym, czy sklejone części po jakimś czasie się nie rozpadną.

Przy projektowaniu procesu technologicznego musisz wziąć pod uwagę całą serię decyzji, które należy podjąć przed zaplanowaniem klejenia.

1. Rozważ, czy kształt złącza jest prawidłowy dla klejenia. Nawet jeśli kleisz pęknięte elementy, możesz dołożyć nakładkę, żebro, wstawić jakiś element łączący. Nie maż bez zastanowienia pierwszym z brzegu klejem typu super-glue, narzekając potem, że te wszystkie kleje są do niczego.

2. Zastanów się nad rozkładem naprężeń. Jakie sztuczki możesz zastosować, żeby połączenie stało się przyjazne klejeniu?

3. Jak przygotujesz podłoże przed klejeniem? Wystarczy tylko odkurzyć, czy należy przeprowadzić zaawansowane mycie w rozpuszczalnikach? Może wystarczy przetrzeć papierowym ręcznikiem zwilżonym alkoholem? A może należy zastosować aktywację plazmową albo fluorowanie?

4. Przed doborem kleju zastanów się nad takimi aspektami, jak maksymalna i minimalna temperatura, w jakiej pracować będzie złącze, środki chemiczne, z jakimi będzie miało kontakt (choćby woda). Sprawdź, czy klej wytrzyma w takich warunkach oraz na ile jest w ogóle pomyślany do wykonywania takich połączeń? Prymitywne instrukcje w supermarketach obiecują cuda. Przeczytaj kartę techniczną kleju, przyjrzyj się jego parametrom technicznym realistycznie.

5. Jakie badania złącza należy przeprowadzić, żeby sprawdzić jego własności w długim czasie? Jak zachowa się po pięciu latach? A po piętnastu? Jakim badaniom przyspieszonym należy poddać złącze, żeby symulacja dała realistyczne wyniki wizualizujące rzeczywistość użytkowania wyrobu?

6. Jak będzie wyglądała technologia wykonania złącza? Jak będziesz klej nakładał? Jak go zmieszasz, jeśli wymaga zmieszania? Jak pozbędziesz się bąbli powietrza w złączu? Jak usuniesz wypływki?

Czy klej rodzaju super glue wypełni szczeliny, jeśli mają więcej niż 0,5 mm? Wypełni tylko estetycznie czy będzie miał jeszcze jakąś wytrzymałość? A jeśli elementy są dopasowane, to czy klej silikonowy będzie dobrze trzymał w szczelinie 0,1 mm?

Jeśli projektujesz proces przemysłowy, zastanów się, jakim urządzeniem klej obrobisz. Chodzi o to, że wiele klejów trzeba wymieszać, nałożyć w określonej ilości, podtrzymać zawiesinę, jeśli mają sedymentujące wypełniacze. Może klej trzeba podgrzać, żeby lepiej wpływał w złącze i szybciej wiązał?

Często, by otrzymać estetyczne złącze w widocznym obszarze, warto zastosować nakładanie kleju robotem lub inną maszyną. Tylko tak możemy nałożyć równomierną linię klejenia na całym złączu.

7. Klej będzie musiał zmienić swój stan skupienia – musisz go poddać utwardzeniu. Inaczej cała operacja nie będzie miała sensu, prawda?

Jak więc utwardzisz klej? Jeśli na przykład klej utwardza się przez kontakt z jonami wilgoci, to jak te jony wilgoci się do złącza dostaną? Klejenie dwóch płyt tworzywowych o powierzchni 500 × 500 mm za pomocą silikonu jednoskładnikowego na całej powierzchni może nie mieć sensu. A jeśli wybrałeś superklej epoksydowy utwardzany na gorąco, to czy materiał rodzimy wytrzyma temperaturę wygrzewania kleju?

Jaki piec zastosujesz? Wsadowy czy tunelowy? Jaki profil pieca należy zastosować, żeby proces utwardzania był najbardziej wydajny?

8. Jak ustalisz złączone elementy? Chodzi mi o to, żebyś nie projektował gigantycznych zacisków jak w obuwnictwie do przyklejenia szybki w obudowie, która może utrzymać się na samej lepkości kleju. Klejenie tworzyw sztucznych nie musi być trudne, czasem wystarczy dwie części nałożyć na siebie i zostawić w spokoju. Ale musimy przewidzieć, że w czasie utwardzania kleju elementy mogą się rozpaść choćby pod własnym ciężarem. I nie wolno ich dociskać, jeśli musimy zachować szczelinę 1 mm pomiędzy nimi, wynikającą z rodzaju kleju.

9. Jak długo trzeba poczekać, zanim klej zwiąże? Jak wielkie pola odkładcze są dopuszczalne? Złączone nie do końca utwardzonym klejem, leżące na polu odkładczym wyroby obciążają konto księgowe „produkcja w toku”.

Ile pieniędzy można zamrozić na „produkcję w toku”?

10. W razie reklamacji, jak ustalisz prawidłowość wykonanego 14 miesięcy wcześniej złącza? Jakimi raportami powinieneś dysponować? Jakie parametry powinny być archiwizowane, a jakie tylko obserwowane? Może należy zaplanować obecność kamery archiwizującej obraz i pomiary ilości i położenia kleju „na mokro” jeszcze przed złączeniem elementów?

Może należy zastosować system monitorujący i archiwizujący dane procesu nakładania kleju w czasie jego dozowania?

Te i inne pytania należy zadać, przystępując do procesu klejenia. Jako inżynier nie weźmiesz drutu wyrwanego z płotu lub zbrojenia i nie zastosujesz go jako elektrody do spawania. Tego nauczono cię na uczelni, że są takie obszary jak metalurgia, spawalnictwo, topniki i inne parametry procesu technologicznego.

Niestety, wiele osób przystępuje do klejenia bez zastanowienia, bez ładu i składu, dobierając pierwszy z brzegu (najczęściej najtańszy) klej, bez planowania i bez podstawowej analizy. A warto to rozważyć, bo klejenie jest przyszłością procesów montażu.

Zagrożenia dla połączeń klejonych

Istnieją zagrożenia dla połączeń klejonych, które są znacznie groźniejsze niż obciążenia mechaniczne same w sobie. Mechaniczne obciążenia pozostawiają często widoczne ślady zniszczenia. Jak włamanie dokonane przez amatora, ślady mechaniczne są łatwe do znalezienia i do wskazania winnego. To, co stanowi trudność w technice klejenia, to zerwania samorzutne, wynikające z długotrwałego działania obciążeń mechanicznych w połączeniu ze zmianami temperatur, agresją chemiczną i innymi podobnymi czynnikami.

Starzenie

Złącza klejone ulegają starzeniu. Oznacza to po prostu, że z czasem robią się coraz słabsze, aż do samoczynnego rozpadnięcia się włącznie. Nie jest to zjawisko nagminne, ale jest faktem. Nie wynika ono wyłącznie ze starzenia się samego utwardzonego kleju. Utwardzony klej jest w sumie tworzywem sztucznym, często chemoutwardzalnym, czyli bardzo trwałym „plastikiem”. Zniszczenie złącza może nastąpić z powodu zerwania adhezyjnego w wyniku podciekania wilgoci lub wody. Dlaczego woda miałaby podciekać? Choćby z powodu obecności resztek separatorów lub brudnej powierzchni przed nałożeniem kleju.

Temperatura

Klejenie ma poważne ograniczenie – wysokie temperatury skutecznie niszczą większość złącz (chociaż są przypadki klejenia wytrzymujące temperatury rzędu kilkuset stopni Celsjusza). Wystarczy sklejone złącze potraktować opalarką… Ale zaraz – w tej książce omawiamy klejenie tworzyw sztucznych, a tworzyw nie traktuje się opalarką, chyba że w celu ich zniszczenia lub zespawania. Mamy więc sytuację, w której temperatura nie jest aż tak ważnym ograniczeniem. Jednak zawsze należy ją rozważyć jako czynnik niszczący złącze. Głównie chodzi mi o zmęczeniowe naprężenia złącza, wywołane zmianami temperatury w czasie eksploatacji.

Skoro rozmawiamy o odporności klejów na podwyższoną temperaturę, warto wiedzieć, że powszechnie stosowana do usuwania farb i powłok lakierniczych opalarka jest też znakomitym narzędziem do demontażu połączeń klejonych oraz do usuwania utwardzonych warstw obnażonego kleju. Zwłaszcza gdy sklejone elementy są wykonane z metali, ceramiki lub szkła, można je delikatnie i bez śladu rozłączyć, wstawiając konstrukcję do piekarnika lub podgrzewając sklejone miejsce opalarką.

Gdy wiemy, że klejone złącze będzie poddane zmiennym temperaturom, a na dodatek mamy do czynienia z tworzywem (PC 67 mm/m·K·10-6) przyklejonym do aluminiowej obudowy (22,2 mm/m·K·10-6), warto zauważyć, że poliwęglan będzie rozszerzał się w przybliżeniu trzykrotnie bardziej! Jeśli nie pozwolimy mu się odkształcić, wprowadzimy wysokie naprężenia, warto się takiej konstrukcji bliżej przyjrzeć pod tym kątem. Resztki kleju podgrzanego opalarką można zeskrobać jak farbę, a potem przygotować złącze do powtórnego sklejenia, jeśli jest taka potrzeba.

Agresja produktów chemicznych

Połączenia klejone są szczelne – to już wiemy. Pokusa jest więc wielka, żeby za pomocą klejenia zamknąć dostęp produktów chemicznych. Nie mówię wyłącznie o zbiornikach na paliwo – choć tu powiedziałbym ciepło, ciepło… bo połączenia klejone opierają się oparom paliwa choćby na łodziach motorowych. Ważniejsze są inne chemikalia, takie jak opary organicznych wyziewów spowodowanych na przykład bliskością zwierząt. W jakich sytuacjach może do tego dojść? A choćby wtedy, gdy kamera, wyłącznik lub czujnik zostają zamontowane w oborze lub chlewni albo kurniku. Są to środowiska wbrew pozorom bardzo agresywne chemicznie. W dzisiejszych czasach, gdy elektronika i różne elementy z tworzyw zastępują metale i inne tradycyjne materiały, trzeba to poważnie brać pod uwagę.

Wilgoć

Wilgoć jest czasem większym zagrożeniem niż woda w postaci deszczu. Deszcze zwykle kiedyś przestają padać, nadchodzi czas lepszej pogody i wiele zmoczonych deszczem rzeczy wysycha. Inaczej rzecz się ma z wilgocią. Woda skraplająca się w obudowach, lampach, wyłącznikach może spowodować podciekanie i rozklejanie się złącz (fachowcy mówią: delaminację). Proces podciekania jest powolny, ale nieustający. Po kilku latach nagle następują pęknięcia, elementy klejone rozpadają się. Często jest już po gwarancji, ale klient mówi przy zakupie następnego urządzenia: „Tylko nie klejone, proszę!”.

Marek Bernaciak

AMB Technic

Źródło rysunków: opracowanie autora

Powyższy tekst to fragment książki p. Marka Bernaciaka pt. „Klejenie tworzyw sztucznych. Wprowadzenie do technologii”, która ma ukazać się jeszcze w tym roku, przed Świętami Bożego Narodzenia*.

artykuł pochodzi z wydania 11 (86) listopad 2014

* Książka jest już dostępna. Szczegóły: http://klejenietworzywsztucznych.pl/

Spośród niewykorzystywanych obecnie zasobów hydroenergetycznych w Polsce o potencjale wynoszącym 6,5 TWh/rok, znacząca część (około 1,7 TWh/rok) przypada na obiekty tak zwanej małej energetyki wodnej – MEW (pod tym pojęciem przyjmuje się w Polsce obiekty o mocy poniżej 5 MW). Zdecydowaną większość obiektów do wykorzystania przez MEW stanowią obiekty o niskim spadzie (42%), co należy uwzględnić w programach produkcji turbin, kładąc nacisk na szybkobieżne turbiny niskospadowe. Turbiny tego typu pozwalają w sposób efektywny zagospodarować obiekty hydrotechniczne, charakteryzujące się relatywnie wysokimi natężeniami przepływu wody przy niskich spadkach (różnicy poziomów wody górnej i dolnej poniżej 4 m słupa wody).

Adam Henke, Adam Góralczyk

W niniejszym artykule przedstawiono najważniejsze wyniki prac projektowo-badawczych, przeprowadzonych w Instytucie Maszyn Przepływowych PAN (IMP), których głównym celem było zaprojektowanie, wykonanie oraz przebadanie nowoczesnego modelu (prototypu) hydrozespołu z turbiną wodną o wysokiej sprawności energetycznej, zwartej konstrukcji oraz z możliwością łatwego montażu. Na podstawie badań tego modelu zaprojektowano typoszereg hydrozespołów z piko- i mikroturbinami, różniących się wielkością i przeznaczonych na obiekty o spadach od 1 m do 4 m słupa wody.

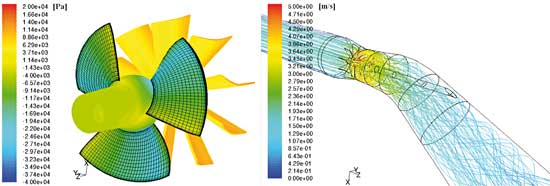

Rys. 1 Rozkład ciśnień statycznych oraz linie prądu kolorowane prędkością całkowitą w warunkach pracy turbiny przy najwyższej sprawności.

Poprzez wprowadzenie narzędzi analizy przepływu i projektowania bryłowego, oraz weryfikację zaprojektowanego układu przepływowego badaniami prototypu na stanowisku laboratoryjnym, uzyskano konstrukcję turbiny charakteryzującej się wysokim poziomem parametrów energetycznych i eksploatacyjnych.

Koncepcja i założenia projektowe turbiny

Po przeprowadzeniu analizy różnych rozwiązań pikoturbin przeznaczonych dla obiektów niskospadowych z założeniem uzyskania wysokiego wyróżnika szybkobieżności przy stosunkowo niskich kosztach instalacji hydrozespołu na obiekcie MEW, zdecydowano się na zaprojektowanie, wykonanie i przebadanie modelu trójłopatkowej rurowej turbiny z wirnikiem Kaplana i przestawianą palisadą kierownicy. Założono, że turbina będzie wyposażona w jednokolanową stożkową rurę ssącą, a odbiór mocy z wirnika będzie się odbywał poprzez wał przechodzący przez kolano rury ssącej.

Własności hydrauliczne turbin wodnych określają ich podstawowe wielkości (parametry): natężenie przepływu Q, wysokość spadu (spad) H oraz szybkość obrotowa wirnika n. Zależność między tymi wielkościami przedstawiona jest często w postaci tzw. kinematycznego wyróżnika szybkobieżności nsQ.

Wyróżnik nsQ jest liczbą kryterialną podobieństwa maszyn hydraulicznych (turbin wodnych i pomp wirowych) i służy do określania kształtu ich wirników oraz typów maszyn (akcyjne lub reakcyjne o przepływie promieniowym, promieniowo-osiowym, osiowym).

gdzie: n –szybkość obrotowa wirnika maszyny [obr/min], Q – objętościowe natężenie przepływu w nominalnych warunkach pracy [m3/s], H – wysokość spadu [m].

Założenia projektowe modelu rurowej turbiny o przyjętym symbolu TNS 300D z wirnikiem Kaplana sformułowano następująco:

- nominalny spad turbiny Hn = 2 m słupa wody,

- nominalna szybkość obrotowa nn = 800 obr/min,

- średnica wirnika D = 300 mm,

- wyróżnik szybkobieżności nSQ » 220,

- liczba łopatek wirnika z = 3,

- liczba łopatek kierownicy regulowanej zk = 14.

Proces projektowania układu przepływowego modelu turbiny przebiegał w dwóch etapach. W pierwszym etapie za pomocą klasycznych metod jednowymiarowych, w oparciu o dane literaturowe oraz własne doświadczenia konstruktorów, wyznaczono geometrię łopatek wirnika oraz kierownicy regulowanej. W drugim etapie projektowania optymalizowano geometrię układu przepływowego turbiny wykorzystując metody CFD.

Rys. 2 Przekrój osiowy modelu turbiny podwójnej regulacji TNS 300D

(1 – kierownica wsporcza, 2 – kierownica regulowana, 3 – obudowa wirnika, 4 – wirnik, 5 – wał, 6 – rura ssąca jednokolanowa, 7 – węzeł łożyska prowadząco-nośnego).

Na rysunku 1 przedstawiono przykładowe wyniki analizy numerycznej układu przepływowego turbiny TNS 300.

Na podstawie wyników przeprowadzonych obliczeń układu przepływowego wykonano projekt konstrukcyjny modeli turbiny (Rys. 2,3).

Rys. 3 Model turbiny TNS 300D – wizualizacja przestrzenna.

Badania modelowe pikoturbin wodnych na stanowisku laboratoryjnym

Stanowisko laboratoryjne do badań modelowych pikoturbin wodnych

Stanowisko uniwersalne do badań modelowych pomp wirowych i turbin wodnych zostało zbudowane w laboratorium Instytutu Maszyn Przepływowych PAN w latach 1973/74. Było ono wykorzystywane głównie do prac związanych z badaniami modelowymi pomp osiowych i niektórych typów turbin wodnych na rzecz rozwoju małej energetyki wodnej w Polsce. Na stanowisku tym prowadzono także zajęcia dydaktyczne ze studentami Politechniki Gdańskiej. W ostatnim czasie, w celu polepszenia warunków napływu na maszynę modelową oraz zwiększenia możliwości badawczych stanowisko przeszło gruntowną modernizację. W ramach tej modernizacji, m.in. zainstalowano zbiornik wyrównawczy po stronie wysokociśnieniowej, o pojemności 12,5 m3, co spowodowało znaczne polepszenie warunków napływu wody do badanych maszyn, zwiększenie dokładności pomiaru natężenia przepływu (wydłużenie ciągów pomiarowych oraz zainstalowanie przepływomierzy magnetoindukcyjnych, które zastąpiły pierwotne zwężki Venturiego), a także znaczne zwiększenie objętości wody obiegowej stanowiska, co przyniosło poprawę warunków termicznych. Wprowadzono również regulację szybkości obrotowej pomp obiegowych stanowiska za pomocą przemienników częstotliwości, co zdecydowanie poprawiło sterowanie pracą stanowiska podczas badań.

Od 2011 roku stanowisko spełnia podstawowe wymogi narzucone przez normę międzynarodową IEC 995, dotyczącą badań modelowych turbin wodnych. Schemat stanowiska przedstawiono na rysunku 4.

Rys. 4 Schemat obiegu hydraulicznego uniwersalnego stanowiska do badań modelowych pomp i turbin wodnych w laboratorium IMP PAN: Zd – zbiornik niskociśnieniowy, Zg – zbiornik wysokociśnieniowy, K – kolektor, T – badana turbina, G – generator, P1, P2 – pompy obiegowe.

W trakcie badań modelowych turbin wodnych obieg wody w układzie hydraulicznym stanowiska zapewniają dwie pompy (P1 i P2 – rys. 4) pracujące ze zmienną szybkością obrotową. Pompy połączone są od strony ssącej ze zbiornikiem niskociśnieniowym Zd, natomiast od strony tłocznej z kolektorem K.

Ciecz wtłoczona do zbiornika kolektorowego kierowana jest na dwa ciągi pomiarowe z przepływomierzami. Woda po przejściu przez ciągi pomiarowe kierowana jest do jednej z komór zbiornika wysokociśnieniowego Zg, następnie przelewa się przez przegrodę w nim umieszczoną do drugiej komory, która połączona jest z króćcem zasilającym badaną turbinę.

Rys. 5 Turbina TSN 300D zainstalowana na stanowisku badawczym

Energia przepływającej wody odbierana jest przez wirnik turbiny i przekazywana poprzez wał do generatora prądu stałego G. Sterowanie szybkością obrotową turbiny odbywa się poprzez regulację wzbudzenia generatora oraz zmianę oporności opornika elektrolitycznego, w którym wytracana jest moc wygenerowana przez prądnicę turbiny. Woda po przejściu przez układ łopatkowy turbiny odprowadzana jest poprzez rurę ssąca oraz kolano do zbiornika niskociśnieniowego.

Na rysunku 5 przedstawiono turbinę TSN 300D zainstalowaną na stanowisku badawczym.

Wielkości charakteryzujące własności energetyczne modelu turbiny i sposób ich pomiaru

Schemat fragmentu stanowiska badawczego obejmującego zainstalowaną turbiną modelową wraz z zaznaczonymi mierzonymi wielkościami został przedstawiony na rysunku 6.

Rys. 6 Schemat stanowiska badawczego z zainstalowaną turbiną modelową wraz z zaznaczonymi miejscami pomiarowymi i wielkościami mierzonymi (1-1 – przekrój wysokociśnieniowy, 2-2 – przekrój niskociśnieniowy, α0 – kąt ustawienia łopatek kierownicy, β – kąt ustawienia łopatek wirnika, M – moment na wale turbiny, n – szybkość obrotowa turbiny, Q – natężenie przepływu, Δ p1-2 – różnica ciśnień statycznych pomiędzy przekrojami wysoko- i niskociśnieniowym)

Jednostkowa energia hydrauliczna turbiny jest zdefiniowana, jako różnica energii jednostkowej wody w wysoko- i niskociśnieniowym przekroju odniesienia (1-1) – na prostym odcinku rury przed wlotem do segmentu kierowniczego i na wylocie z rury ssącej (2-2). Dla wyznaczenia jednostkowej energii hydraulicznej stosuje się wzór:

gdzie: p1 oznacza ciśnienie w przekroju wysokociśnieniowym (przekrój wlotowy turbiny), p2 oznacza ciśnienie w przekroju niskociśnieniowym (przekrój wylotowy z rury ssącej), V1 jest średnią prędkością cieczy w przekroju wysokociśnieniowym liczoną z równania V1 = Q/A1, gdzie: A1 oznacza pole przekroju wysokociśnieniowego, V2 jest średnią prędkością cieczy w przekroju wylotowym rury ssącej w miejscu zainstalowanego wielopunktowego odbioru ciśnienia.

Prędkość V2 jest liczona z zależności V2 = Q/A2, gdzie: A2 – pole przekroju rury ssącej w miejscu zainstalowanego wielopunktowego odbioru ciśnienia, z1 – rzędna przetwornika ciśnienia w przekroju wysokociśnieniowym (1-1), z2 – rzędna przetwornika ciśnienia w przekroju niskociśnieniowym (2-2), g – przyspieszenie ziemskie, ρ – gęstość wody wyznaczona dla aktualnego ciśnienia atmosferycznego i aktualnej temperatury wody.

Przekroje: wysokociśnieniowy i niskociśnieniowy wyposażone były w wielopunktowe odbiory ciśnienia.

Spad netto turbiny Hn [m sł. wody] wyznaczany jest ze wzoru:

W celu zwiększenia dokładności pomiaru spadu, zamiast oddzielnych pomiarów ciśnień p1 i p2, mierzono różnicę ciśnień Δ p1-2 za pomocą przetwornika różnicowego. W tych warunkach spad turbiny wyznaczano ze wzoru:

Do pomiaru objętościowego natężenia przepływu Q [m3/s] (strumienia objętości) wody) posługiwano się dwoma zainstalowanymi na stanowisku przepływomierzami magneto-indukcyjnymi.

Moc na wale badanej turbiny mierzono w sposób pośredni, za pomocą pomiaru momentu obrotowego i szybkości obrotowej wirnika turbiny, a jej wartość obliczano ze wzoru:

gdzie: P – moc [W], M – moment obrotowy [Nm], n – szybkość obrotowa [obr/min].

Szybkość obrotowa wirnika badanej turbiny n była mierzona za pomocą przetwornika impulsowego. Moment obrotowy na wale badanej turbiny M był mierzony za pomocą momentomierza. Ze zmierzonych wartości natężenia przepływu Q, szybkości obrotowej n, momentu obrotowego na wale M oraz mocy mechanicznej na wale P wyznaczano sprawność całkowitą turbiny η, która wyraża stosunek energii mechanicznej na wale turbiny do energii hydraulicznej strumienia cieczy przepływającego przez turbinę, co zapisać można wzorem:

Zakres badań oraz ich przebieg

Badania modelu turbiny TNS 300D wykonano przy spadach netto Hn ~ 1.5 m, dla ośmiu ustawień łopatek wirnika β w zakresie 6÷24°. Szybkość obrotową n zmieniano w przedziale 250÷1100 obr/min.

Badania polegały na równoczesnym pomiarze natężenia przepływu Q, różnicy ciśnień statycznych między przekrojem wlotowym i wylotowym turbiny ∆p, momentu obrotowego M na wale turbiny oraz szybkości obrotowej wirnika n, przy różnych obciążeniach badanej turbiny. Na podstawie zmierzonych wielkości wyznaczone zostały: spad netto turbiny Hn, moc mechaniczną na wale turbiny P oraz sprawność całkowita η.

Uzyskane z pomiarów wartości natężenia przepływu, szybkości obrotowej, momentu obrotowego na wale oraz mocy mechanicznej na wale były redukowane (przeliczane) na średni spad turbiny Hred, utrzymywany w trakcie badań na stałym poziomie.

Wyniki badań

Na rysunku 7 przedstawiono przykładowe wyniki badań modelu turbiny TNS 300D, uzyskane przy kącie ustawienia łopatek wirnika β = 16° i kącie ustawienia łopatek kierownicy αo = 45° oraz spadzie H = 1,5 m sł. wody

Rys. 7 Przykładowe wyniki badań modelu turbiny TNS 300D, uzyskane przy kącie ustawienia łopatek wirnika β = 16° i kącie ustawienia łopatek kierownicy αo = 45° oraz spadzie H = 1,5 m sł. wody.

Wyniki te przedstawiono w postaci krzywych natężenia przepływu Q, mocy na wale P i sprawności η w zależności od szybkości obrotowej n. Krzywe (wielomiany piątego lub szóstego stopnia) wyznaczono metodą najmniejszych kwadratów, zastosowanych do wartości wielkości mierzonych podczas badań.

Kolejnym etapem obróbki danych pomiarowych było przedstawienie wszystkich wyników badań w postaci tzw. charakterystyki uniwersalnej (muszlowej) badanej turbiny modelowej. Charakterystykę tę definiowano, jako zależność sprawności turbiny η od szybkości podwójnie zredukowanej n11 i podwójnie zredukowanego objętościowego natężenia przepływu Q11 z zaznaczeniem linii stałych kątów ustawienia łopatek wirnika, oraz linii stałych kątów ustawienia łopatek kierownicy. Wielkości n11 i Q11 (podwójnie zredukowane na spad H = 1 m i średnicę wirnika D =1 m), obliczano ze wzorów:

Wyznaczoną na podstawie przeprowadzonych badań charakterystykę uniwersalną modelu turbiny podwójnej regulacji TSN 300D przedstawiono na rysunku 8.

Nomogram wyznaczonego typoszeregu pikoturbin

Na podstawie wyników przeprowadzonych badań modelowych oraz przyjętego sposobu uwzględnienia efektu skali opracowano nomogram turbin typoszeregu TNS.

Rys. 8 Charakterystyka uniwersalna modelu turbiny TNS 300D

Nomogram ten, przedstawiony na rysunku 9, służy do wstępnego doboru turbin i do orientacyjnego określenia parametrów turbiny (moc, szybkość obrotowa) dla warunków energetycznych (spad, przepływ) występujących na danym obiekcie.

Rys. 9 Nomogram turbin opracowanego typoszeregu TNS D.

Do dokładnego wyznaczania parametrów turbin należy posługiwać się charakterystykami uniwersalnymi turbin.

Przeliczenie współczynnika sprawności na warunki rzeczywiste

Podstawowym wymaganiem dotyczącym wyznaczania własności ruchowych prototypu na podstawie badań modelowych jest zachowanie podobieństwa hydrodynamicznego między modelem a prototypem. Osiągnięcie takiej relacji wymaga zachowania podobieństwa geometrycznego (homologii) oraz identycznych stosunków różnych sił działających między cieczą, a elementami każdej maszyny. Stosunki te zdefiniowane są wyrażeniami bezwymiarowymi i identyfikowane liczbami podobieństwa. Normy dotyczące badań modelowych określają dopuszczalne odchyłki wymiarów poszczególnych części układu przepływowego prototypu w odniesieniu do modelu w celu spełnienia warunków podobieństwa geometrycznego.

Podobieństwo kinematyczne prototypu i modelu jest spełnione, gdy zachodzi równość:

gdzie: Q – objętościowe natężenie przepływu [m3/s], n – szybkość obrotowa [obr/min], D – średnica wirnika [m], indeks M dotyczy modelu, indeks P dotyczy prototypu.

Podobieństwo dynamiczne pomiędzy modelem i prototypem zachowane jest, gdy stosunki między siłami mającymi wyczuwalny wpływ na przebieg zachodzących zjawisk w obu porównywanych układach są równe. Siłami tymi są siły ciśnienia, bezwładności i lepkości. Podobieństwo sił ciśnienia i bezwładności określa liczba Eulera Eu:

gdzie: P – ciśnienie, ρ – gęstość, V – prędkość.

Podobieństwo sił lepkości i bezwładności wyraża liczba Reynoldsa:

gdzie: ν – lepkość kinematyczna.

Przy założeniu, że νP=νM oraz przyspieszenie ziemskie g = const otrzymujemy warunek:

który jest niezwykle trudny do spełnienia (w praktyce spotyka się stosunki liczb Reynoldsa modelu i prototypu sięgające sześćdziesięciu).

Z tego powodu, przy wyznaczaniu sprawności prototypu na podstawie badań modelowych należy uwzględnić efekt skali. W przypadku turbin w typoszeregu TSN D posłużono się metodami zalecanymi przez normę IEC 995.

Sprawności maksymalne turbin typoszeregu TNS D przedstawiono w tabeli 1.

Tabela 1 Maksymalne wartości sprawności turbin typoszeregu TNS D wyznaczone na podstawie badań modelowych z uwzględnieniem efektu skali według zaleceń normy IEC 995

Podsumowanie i wnioski

Artykuł przedstawia procedury związane z badaniami modelowymi turbiny o przepływie osiowym (typu Kaplana) przeznaczonej do pracy na małych obiektach hydrotechnicznych o niskich spadach. Procedury te obejmują:

- zaprojektowanie układu przepływowego turbiny,

- sporządzenie dokumentacji konstrukcyjnej modelu turbiny,

- wykonanie turbiny i jej posadowienie na stanowisku badawczym,

- opracowanie charakterystyki uniwersalnej (muszlowej) turbiny,

- opracowanie typoszeregu turbin w oparciu o rezultaty badań modelowych.

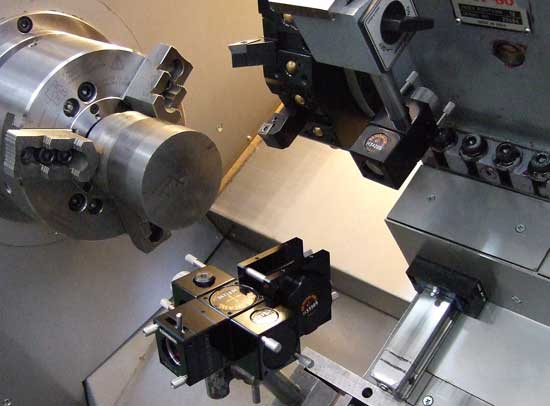

Projektowanie turbiny modelowej oparto o własne, wcześniej opracowane narzędzia obliczeniowe oraz o współczesne programy obliczeniowe CFD. Łopatki wirnika i kierownic turbiny wykonano z wykorzystaniem precyzyjnych obrabiarek, sterowanych cyfrowo. Badania modelowe przeprowadzono na unikatowym w Polsce stanowisku laboratoryjnym w IMP PAN w Gdańsku, przeznaczonym do badań modeli pomp wirowych i turbin hydraulicznych.

Przeprowadzone badania laboratoryjne j turbiny modelowej pozwoliły na uzyskanie jej pełnej charakterystyki uniwersalnej (muszlowej). Charakterystykę te przedstawiono w postaci wielkości jednostkowych i bezwymiarowych, jako zależność sprawności turbiny η od szybkości podwójnie zredukowanej n11 i podwójnie zredukowanego objętościowego natężenia przepływu Q11 z zaznaczeniem linii stałych kątów ustawienia łopatek wirnika oraz linii stałych kątów ustawienia kierownicy.

Wyniki przeprowadzonych badań posłużyły do opracowania typoszeregu turbin TNS D. Przy przenoszeniu wyników badań modelowych na warunki, w których przewiduje się zastosowanie podobnych turbin prototypowych, uwzględniono zasady podobieństwa maszyn hydraulicznych i efekt skali.

Na podstawie przeprowadzonych analiz oraz prac konstrukcyjnych i badawczych sformułowano następujące najważniejsze wnioski dotyczące opracowanych nowych konstrukcji turbin:

Badania modelu rurowej turbiny typu Kaplana TNS 300D pozwoliły na wyznaczenie jej własności energetycznych (charakterystyk) w szerokim zakresie zmienności nastaw regulacyjnych i parametrów jej pracy.

Turbina modelowa osiągnęła dość wysoką sprawność maksymalną ηmax = 0,862 dla podwójnie zredukowanej wartość szybkości obrotowej n11 = 157 obr/min i podwójnie zredukowanego natężenia przepływu Q11 = 1,65 m3/s, przy kącie ustawienia łopatek wirnika β = 16º oraz kącie ustawienia łopatek kierownicy αo = 45º.

Wartość kinematycznego wyróżnika szybkobieżności w optymalnym punkcie pracy wynosi nSQ = 202 (nieco mniejsza niż założona nSQ » 220). Uzyskana wartość nSQ pozwala określić badaną turbinę, jako szybkobieżną, przeznaczoną do pracy przy relatywnie niskich spadach oraz wysokich natężeniach przepływu.

Turbina charakteryzuje się bardzo szerokim zakresem obciążenia (pracy) z wysoką sprawnością. W zakresie Q11=1,0 ÷ 2,2 m3/s, sprawność turbiny h ≥ 80%. Korzystnym jest więc stosowanie tej turbiny na obiektach o dużej zmienności przepływu.

mgr inż. Adam Henke

główny specjalista

mgr inż. Adam Góralczyk

starszy specjalista

Instytut Maszyn Przepływowych PAN, Gdańsk

LITERATURA

Miąskowski W., Adamkowski A., Nalepa K., Pietkiewicz P.,

Henke A., Góralczyk A., Kaniecki M.: Mikrogeneracja energii z wiatru i wody, Wydawnictwa Instytutu Maszyn

Przepływowych PAN, Gdańsk 2014.

artykuł pochodzi z wydania 10 (85) październik 2014

Chociaż artykuł ten opisuje przede wszystkim jak diagnozować błędy wykonania detali przy obróbkach specjalnych na tokarkach, to może on być także wskazówką ogólną, jak podejść do diagnostyki przyczyn błędów obróbki wynikających z dokładności wykonania i działania wszystkich obrabiarek, zakładając poprawne stosowanie technologii obróbki.

Robert Jastrzębski

W poprzedniej części przedstawione zostały podstawowe założenia opisywanego sposobu diagnostyki rozpatrującego błędy realizowanych trajektorii zadanych ruchów technologicznych narzędzia i przedmiotu obrabianego, a także wskazówki, jak wykorzystać do oceny dokładności realizowanych ruchów technologicznych, możliwości diagnostyczne dwóch metod badań dokładności obrabiarek CNC, wynikających z przepisów badań obrabiarek (Rys. 1).

Rys. 1 Pomiar dokładności wirującej osi stołu obrotowego

Jednak dla niektórych specjalnych rodzajów obróbki złożonej standardowe metody badań obrabiarek mogą nie wystarczyć do oceny powstających błędów obróbki, dlatego w tej części artykułu zdecydowałem się na opis specjalnej metody pomiarów chwilowych prędkości obrotowych, jako przykład uchwycenia zjawisk dynamiki ruchu obrotowego wyjaśniających błędy powstające przy niektórych rodzajach obróbki złożonej na tokarkach.

Pomiar dokładności i równomierności zadanych prędkości osi obrotowych

Specjalna metoda przydatna do oceny błędów obróbki na tokarkach wykorzystujących synchronizację: prędkości dwóch wrzecion (np. obróbka z przechwytem przedmiotu), stałego przełożenia prędkości wrzeciona i narzędzia (np. obróbka wielokątów) lub prędkości wrzeciona i zadanej trajektorii osi posuwowej, w zakresie oceny błędów prędkości i ich wpływu na uzyskiwane kształty. Metoda została opracowana i wdrożona przeze mnie w ramach realizowanego w latach 2010-2012 w CBKO projektu badawczego. Podstawowa zaleta tej metody to możliwość pomiaru chwilowych prędkości na bardzo krótkich odcinkach drogi (od 5 µm) i krótkich odcinkach czasu (zrealizowano możliwość próbkowania co 12,5 ns).

Rys. 2 Schemat pomiaru prędkości chwilowej wrzeciona

Dla potrzeb badań odchyleń chwilowych od zadanej prędkości obrotowej, pomiary prędkości w odstępach czasu wyższych od 1 ms są nieprzydatne, zbyt mocno uśrednione, dla zjawisk zachodzących przy obróbce. Z kolei dla dokładnego pomiaru chwilowej prędkości obrotowej na drodze kątowej ułamka obrotu przy prędkościach obrotowych stosowanych do obróbek specjalnych na tokarce, pojawia się problem bardzo dokładnego pomiaru drogi i bardzo krótkich odcinków czasu (rzędu nanometrów i nanosekund). Przykładowo: dla 1000 obr/min i tylko dla 60 pkt/obr, czas pomiaru 1/60 obrotu wynosi 1 ms. Dla zachowania dokładności co najmniej 1% czas 1/60 obrotu należy zmierzyć z dokładnością w nanosekundach, a wymagana dokładność pomiaru prędkości będzie zachowana przy odmierzaniu czasu z bardzo dokładnych odcinków drogi.

Rozwiązano to następująco: zastosowano enkoder z pomiarem optycznym bezstykowym o 11840 imp/obr, o dokładności 7”/360º i rozdzielczości impulsów co 5 µm. Dokładność pomiaru drogi dla pełnego obrotu wynosi 0,18 µm, a na impuls jest nie gorsza niż 0,001 µm (0,02%/5 µm). Czas pomiędzy impulsami mierzono metodą licznikową, wprowadzając standardowy sygnał z enkodera na wejścia licznikowe posiadanej karty pomiarowej taktowane częstotliwością 80 MHz. Daje to dokładność pomiaru czasu ±6,25 ns. Pomiary i obliczenia prędkości chwilowej obsługuje program własny napisany w środowisku LabView. Metoda jest uniwersalna, pozwala wykorzystać każdy przetwornik obrotowo impulsowy o standardowym sygnale TTL. Niepewność pomiaru prędkości chwilowej zależy od dokładności i rozdzielczości przemieszczenia kątowego zastosowanego przetwornika oraz podanej dokładności pomiaru czasu. Rysunek 2 przedstawia schemat zrealizowanego układu pomiarowego.

Przykład wykorzystania metody:

Wpływ błędów chwilowej prędkości obrotowej wrzecion na dokładność położenia kątowego po przechwycie.

Obróbkę z przechwytem przedmiotu obrabianego przez drugie wrzeciono, tzw. przechwytujące, stosuje się przy wysokowydajnej obróbce przedmiotów symetrycznych, obrabianych z obu stron. Przechwyt następuje bez zatrzymywania obrotów, przy jednoczesnej synchronizacji prędkości i położenia kątowego wirujących osi wrzecion. Jeśli istotne jest dla przedmiotu obrabianego zachowanie położenia kątowego po przechwycie, to do oceny tej dokładności można zastosować przedstawioną metodę pomiaru dokładności i równomierności nastawionej prędkości obrotowej. Na rysunku 3 przedstawiono wynik pomiaru prędkości obrotowej wrzeciona (z 50 obrotów), pracującego w trybie synchronizacji z wrzecionem przechwytującym dla nastawy 1200 obr/min.

Rys. 3 Wynik pomiaru prędkości chwilowej wrzeciona pracującego w trybie synchronizacji obrotów z wrzecionem przechwytującym dla nastawy 1200 obr/min w czasie 2,5 sek. (50 obr.) z częstością próbkowania 240 pkt/obr.

Dla oceny mogących wystąpić błędów kątowych istotna jest równomierność prędkości (błąd wartości średniej w stosunku do nastawy nie ma tu znaczenia, gdyż wartości średnie prędkości dla obu wrzecion są w tym trybie pracy takie same), a w ciągłym procesie doregulowywania się pozycji kątowej i prędkości występują chwilowe oscylacje wynikające z dynamiki ruchu i działania regulatorów prędkości. Wielkości tych zmian uwidocznił pomiar prędkości chwilowej (Rys. 3).

Wpływ oscylacji w stanie synchronizacji na wzajemne kątowe położenie wrzecion można oszacować przy założeniu, że prędkość jednego z wrzecion jest stała, a drugie przyspiesza jednostajnie na określonej drodze kątowej. Podstawa tych założeń wynika z analizy zarejestrowanych przebiegów prędkości obrotowej obu wrzecion w stanie synchronizacji, gdzie różnice pomiędzy max. i min. występowały w rozpatrywanym przypadku nie szybciej niż na drodze kątowej równej ½ obrotu. Zakładając prędkość początkową obu wrzecion, jako zarejestrowaną minimalną V0 = 1191 obr/min, po czym jedno z nich w ciągu pół obrotu osiąga prędkość max. V1 = 1196 obr/min, można wyliczyć przyspieszenie:

gdzie czas t odpowiada czasowi, jaki trwa pół obrotu wrzeciona przy prędkości stałej (V0), równej 1191 obr/min (t = 0,02519 sek.).

Znając przyspieszenie i warunki początkowe, można wyliczyć drogę kątową, jaką przebędzie wrzeciono przyspieszające jednostajne w czasie t:

Różnica pozycji kątowej, jaka wytworzy się wtedy pomiędzy dwoma wrzecionami, będzie równa 0,379°. Jeśli w tym momencie nastąpi zaciśnięcie się szczęk wrzeciona przechwytującego na przedmiocie, to różnica ta pozostanie po przechwycie, jako błąd. Można ją przyjąć dla 1200 obr/min., jako maksymalną składową błędu przechwytu od dokładności synchronizacji prędkości. Dla zmniejszenia błędu kątowego po przechwycie należałoby albo zmniejszyć prędkości obrotowe przy przechwycie lub dokonać ewentualnych regulacji.

Rys. 4 Przykład obróbki złożonej

Wykorzystując przedstawioną metodę pomiaru prędkości chwilowych można było oszacować błędy obróbki od ruchów obrotowych dla wymienionych na wstępie rodzajów obróbki:

- wysokowydajne „toczenie” wielokątów [1],

- obróbka gwintów falistych,

- opisana obróbka z przechwytem.

Jednocześnie metoda pozwala na lepsze poznanie zjawisk dynamicznych występujących przy obróbce, wpływu zmian nastaw regulatorów prędkości oraz diagnostykę przyczyn błędów nastawionej prędkości obrotowej. Pozwala też, przy 32 bitowych licznikach, także na pomiar równomierności i dokładności bardzo niskich prędkości obrotowych.

W tabeli 1 przedstawiono wytyczne do diagnostyki wrzecion obrotowych na podstawie opisanej metodyki pomiarów.

Tab. 1 wytyczne do diagnostyki wrzecion na podstawie opisanej metodyki

Przykład diagnostyki przyczyn błędów kształtu toczenia kuli

Zgłoszono mi problem wytoczenia na tokarce przedmiotu z powierzchnią kulistą (Rys. 5) o średnicy 50 mm w detalu stalowym z zakładaną odchyłką nie gorszą niż 30 µm.

Rys. 5 Obrabiany przedmiot z powierzchnią kulistą

Pomiary po wstępnych próbach toczenia wykazywały błędy kształtu kuli 40-50 µm. Przy toczeniu kuli realizowane są ruchy technologiczne – interpolacji po okręgu osi posuwowych w płaszczyźnie XZ i ruch obrotowy zamocowanego w uchwycie przedmiotu. Wynika stąd, że aby znaleźć przyczyny błędów kształtu toczonej kuli, należy zastosować co najmniej dwie metody – test interpolacji kołowej i test błędnych ruchów wirujących osi (opisane w części pierwszej artykułu). Wskazane jest, aby test interpolacji kołowej przeprowadzić tak, aby prędkość ruchu interpolowanego o zadanym promieniu odpowiadała prędkości przy obróbce kuli. Wtedy dość wiarygodnie można oszacować spodziewane błędy kształtu toczonej kuli w płaszczyźnie XZ. Natomiast w płaszczyźnie toczenia, na owalność toczonej kuli wpływa dodatkowo wprost błąd synchroniczny ruchów promieniowych wirującej osi, dla zadanej prędkości obrotowej toczenia. Typowe błędy nastawienia prędkości obrotowej wrzeciona nie mają w tym przypadku większego znaczenia.

Przeprowadzone badania wykazały następujące błędy ruchów:

z testu interpolacji kołowej dla r = 50 i V = 5000 mm/min najbardziej istotne to: błąd nadążania 0,5 ms i błędy wpływające na odwzorowanie konturu kuli: luz zwrotny 3 µm, nieprostopadłość osi posuwowych 160 µm/m i różnica skali osi X i Z 11 µm na śr. φ100 mm.

z testu błędnych ruchów wirującej osi wykonanym przy takich samych obrotach jak obróbka kul najbardziej istotny błąd to promieniowy błąd synchroniczny ok. 6 µm, wpływający na owalność kuli w płaszczyźnie XY.

Mając wyniki badań należy poprawnie przełożyć wpływ zdiagnozowanych błędów na błąd okrągłości toczonej kuli (np. nieprostopadłość osi 160 µm/m przekłada się na błąd okrągłości 8 µm na śr. φ50 mm.

I tak, otrzymujemy:

Maksymalny błąd trajektorii wynikający z błędu nadążania w płaszczyźnie XZ wynosi:

ΔnadążXZ = 5000 mm/min * 0,5 ms/60000 ms = 41,7 µm

Z wymienionych błędów odwzorowania konturu z testu interpolacji, składając je jako pierwiastek z sumy kwadratów, oraz przeliczając na kulę φ50, otrzymujemy:

ΔkontXZ i XY. ≈ 10 µm

Błąd synchroniczny ruchów promieniowych wirującej osi przekłada się bezpośrednio na błąd trajektorii, powodujący owal toczonej powierzchni w płaszczyźnie toczenia XY:

ΔkontXY ≈ 6 µm

Z analizy tej wynika, że podstawowy problem tkwił w za dużym błędzie nadążania ruchu interpolowanego, przy zadanej prędkości 5000 mm/min. Rozwiązaniem jest zmniejszenie prędkości ruchu interpolowanego lub optymalizacja wzmocnień serwonapędów dla zadanej prędkości obróbki, jeśli ma być utrzymana wydajność obróbki. Napędy optymalizowano prawdopodobnie dla znacznie mniejszych prędkości lub wcale, pozostawiając ustawienia standardowe. Zastosowane metody wskazały najistotniejsze przyczyny błędów obróbki kuli i sposób rozwiązania podstawowego problemu. Przy obróbce wielkoseryjnej dodatkowo powinno się sprawdzić dryfty temperaturowe suportu i wrzeciona, do pełnej oceny zdolności produkcyjnej badanej tokarki przy tej obróbce.

Podsumowanie

Diagnostyka błędów obróbki, wynikająca z błędów wykonania obrabiarek, nie jest prosta, wymaga doświadczenia w stosowaniu metod badań, aby je poprawnie wykorzystywać, oszacować niepewność pomiarów oraz nie wysnuwać pochopnych wniosków z diagnostyki, gdyż wyniki badań potrafią zaskakiwać i mogą być trudne do interpretacji. Jednym z większych problemów może być tu ocena, jakie błędy wykonania obrabiarki są istotne dla danego rodzaju obróbki i w jaki sposób przekładają się na dokładność obrabianych przedmiotów.

Rys. 6 Pomiary dokładności pozycjonowania osi X tokarki odchylonej od poziomu

Dla potwierdzenia uzyskiwania czasem nie oczywistych, trudnych do interpretacji i zaskakujących wyników badań – dwa przykłady takich wyników.

Rys. 7 Przykładowe błędy pozycjonowania osi posuwowej obrabiarki

Rysunek 7 to wykres dokładności pozycjonowania osi posuwowej obrabiarki z zaskakującymi „schodkami”, a następnie mój ulubiony wynik z diagnostyki błędnych ruchów osi wrzeciona tokarki (Rys. 8).

Rys. 8 Wykres błędnych ruchów osi wrzeciona w funkcji kąta obrotu

Ja oczywiście znam przyczyny takich wyników, ale dla chętnych proponuję chwilę refleksji i puszczenie wodzy fantazji.

Na koniec chciałbym zwrócić jeszcze uwagę, że:

- Najczęściej błędy danej obróbki wynikają z kilku lub więcej różnych błędów danej obrabiarki i składają się w sposób absolutnie przypadkowy.

- Opisane przykładowe trzy metody badań (dwie opisane w części pierwszej artykułu, wynikające z przepisów badań obrabiarek i jedna specjalna, opisana powyżej) w moim mniemaniu posiadają duże możliwości diagnostyczne i odpowiednio stosowane pozwalają na dość dobrą ocenę przyczyn błędów obróbki oraz sprawdzanie efektów przeprowadzanych regulacji i/lub napraw.

- Mierzone błędy dokładności obrabiarek (geometryczne, kinematyczne, cieplne, pozycjonowania) oraz wyznaczane wskaźniki dokładności z testów odbiorczych, nie odzwierciedlają, w przypadkach obróbki wykorzystującej złożenie ruchów technologicznych, uzyskiwanych dokładności obróbki.

- Przedstawiony sposób diagnostyki, w postaci analizy dokładności realizacji zadanych trajektorii ruchów technologicznych, wydaje się być dość uniwersalny i da się zastosować do większości rodzajów obróbki, jednocześnie wskazując, gdzie tkwią główne przyczyny błędów rozpatrywanego rodzaju obróbki.

Robert Jastrzębski

SciLab Measurements

Literatura

[1] Jastrzębski R., Jak diagnozować przyczyny błędów obróbki CNC cz. 1, Projektowanie i Konstrukcje Inżynierskie, nr 7/8 (60) lipiec/sierpień 2014, str. 22-27

[2] Jastrzębski R., Madej L., Wpływ cyklicznej niestabilności prędkości obrotowej narzędzia na płaskość powierzchni obrobionej przy toczeniu wielokątów, 7 Międzynarodowa Konferencja „Inżynieria produkcji 2011” 30.05-01.06.2011 Wrocław. Materiały konferencyjne.

[3] Jemielniak K., Analiza błędnych ruchów wrzecion szybkoobrotowych, Archiwum Technologii

[4] Jastrzębski R., Obróbka gwintów falistych i trapezowych na uniwersalnej tokarce CNC, Projektowanie i Konstrukcje Inżynierskie, nr 9 (60) wrzesień 2012, s. 52-57

[5] Majda P., Jastrzębski R., Wyniki porównawczych badań międzylaboratoryjnych, na przykładzie pomiarów dokładności i powtarzalności pozycjonowania liniowych osi frezarki sterowanej numerycznie, Przegląd Mechaniczny, zeszyt 11/2011, s. 17-24

artykuł pochodzi z wydania 9 (84) wrzesień 2014

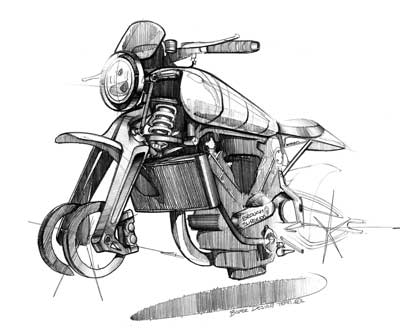

Marka Brough Superior ciągle jest synonimem najwyższej jakości, stylu i doskonałych osiągów. Motocykle z jej logo są ozdobą najcenniejszych kolekcji. Jedną z największych sensacji ubiegłorocznych targów motocyklowych w Mediolanie była zapowiedź powrotu marki.

Ryszard Romanowski

Właściwie trudno pisać o firmie Brough Superior nie wspominając o ojcu jej założyciela Williamie Brough. Urodził się on w 1861 roku w środku rewolucji przemysłowej i w czasach, kiedy to transport drogowy zaczął się burzliwie zmieniać. Myślał i pracował po 24 godziny na dobę, aby stworzyć coś na miarę epoki.

Udało się. Pierwszy pojazd motorowy jego konstrukcji powstał w ostatniej dekadzie XIX stulecia. Od 1899 roku ojciec z synem przemierzali brytyjskie drogi maszyną napędzaną silnikiem De Dion. W 1902 roku powstał pierwszy motocykl. Krótko później ojciec na swojej maszynie zdobył zloty medal w ACC End to End Trial. Ojciec z synem doskonale się rozumieli. Trwała produkcja motocykli, minęła I wojna światowa i syn wpadł na pomysł budowy najdoskonalszych maszyn, jakie wówczas można było sobie wyobrazić. Już w założeniu nie miały one być zwykłymi środkami transportu jak motocykle innych marek.

Wystarczyło aby George Brough na jednym z przyjęć przedstawił założenia konstrukcyjne nowych motocykli i projekt dodania do nazwy członu Superior, aby powstała jedna z wielu anegdot krążących wokół firmy. Stojący wtedy obok niego Charles Edmund Allen udał, że niedosłyszy i pochwalił trafną nazwę Brough Inferior... Na marginesie warto przypomnieć, że C. E. Allen to najsłynniejszy chyba dziennikarz motocyklowy na świecie urodzony w 1915 roku.

Nie przewidywał, że niemal do śmierci w 2010 nie rozstanie się z motocyklami. Nie przewidywał również, że kilka lat po zacytowanej wypowiedzi rzuci na długo zawód dziennikarza zostając przedstawicielem handlowym swojej ukochanej marki Brough Superior.

Niezwykły pod każdym względem

Produkcja przy Haydn Road w Nottingham ruszyła w 1919 roku i zgodnie z założeniami nie chodziło w niej o ilość. Tylko w 1927 roku wyprodukowano ponad 200 motocykli, na ogół nie przekraczano 150 sztuk rocznie. Przez dwadzieścia jeden lat zbudowano 3048 maszyn, z czego co najmniej 1000 jeździ do dzisiaj. Powstało dziewiętnaście modeli, a mimo to trudno było spotkać dwa identyczne. Każdy motocykl powstawał zgodnie ze wskazówkami przyszłego właściciela. Z założenia nie produkowano silników.

Zamawiano je w uznanych przez wytwórnię firmach. Najczęściej używano silników JAP. Skonstruowano również czterocylindrowy motocykl wykorzystując silnik Austina Seven. Szybko uznano Brough Superiora za Rolls Royce’a wśród motocykli. Nie tylko chodziło tu o precyzję montażu, jakość materiałów, niezawodność i wysokie osiągi. Firma stosowała niespotykane dotąd procedury. Motocykle były dokładnie montowane i sprawdzane, następnie rozmontowywano je, aby wprowadzić odpowiednie pokrycia oraz zabezpieczenia antykorozyjne i ozdobne. Przy okazji korygowano drobne błędy.

Jakość elementów chromowanych Superiorów jest już legendarna. Warstwy chromu na grubych powłokach miedzianych nie poddają się upływowi czasu i warunkom atmosferycznym. Podobno wszystkie maszyny, które przetrwały do dzisiaj mają oryginalne chromy.

Motocykle te miały również sylwetkę będącą według wielu ponadczasową kwintesencją jednośladu. Zawsze sprawiały wrażenie lekkich i takie były. Najcięższe modele SS 100 rzadko kiedy przekraczały wagą 200 kg. Przednie zawieszenie przypominało działaniem popularny wówczas trapez, lecz było bardziej zwarte od rozwiązań innych marek. W roku 1925 wprowadzono tzw. Castle forks, rozwiązanie niemal identyczne z harleyowskim Springerem stosowanym w Milwaukee od 1930 roku. Centralny amortyzator tylnego zawieszenia umieszczono poziomo w górnej części ramy, dzięki czemu był niemal niewidoczny. W wielu, w tym rekordowych, wersjach stosowano resor piórowy i amortyzatory cierne. To rozwiązanie również sprawiało wrażenie, że tylna część ramy jest sztywna.

Podobne rozwiązanie powróciło w chwale po wielu dekadach w popularnych markach. Oznaczenia cyfrowe najsłynniejszych modeli SS 80 i SS 100 mówiły o prędkości maksymalnej motocykli. Jeżeli odpowiedni model nie pojechał prędzej niż 80 mil czyli ok. 130 km/h lub 100 mil czyli nieco ponad 160 km/h to wracał do fabryki, gdzie dokonywano poprawek. Model SS 80 powstał w 1923 r., a SS 100 miał premierę na słynnym przez długie lata Olympia Show w listopadzie 1924 roku. Wtedy takie prędkości seryjnych motocykli można było uznać naprawdę za niezwykłe.

Nawet dzisiaj Superiory na drodze nie odstawałyby zbytnio od motocykli turystycznych. Tym bardziej, że były egzemplarze już w fabryce dostosowywane do wyższych prędkości. Padały rekordy szybkości, firmowi zawodnicy zwyciężali na torach i w wyścigach górskich. Już w 1928 roku sam George Brough osiągnął w Arpajon na niczym nieosłoniętym SS 100 prędkość 210,2 km/h. Perfekcyjne i piękne maszyny oraz charyzmatyczna postać właściciela firmy przyciągały słynnych klientów.

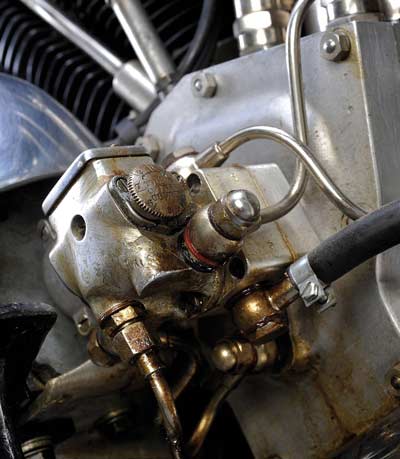

George Bernard Shaw często pisywał i wypowiadał się z zachwytem o marce. Słynny Thomas Edward Lawrence, znany jako Lawrence z Arabii, krótkie chwile pobytu w ojczyźnie najczęściej spędzał za kierownicą swojego Brough Superiora. Właśnie w 1934 miał odebrać nową maszynę. Niestety było coś nie tak z gaźnikiem. Po poprawkach w firmie AMAL SS 100 nazwany George VII był gotowy. Lawrence mógł go sprawdzić dopiero w maju 1935 roku.

Podczas szybkiej jazdy wąską, otoczoną żywopłotami, drogą zobaczył na jej środku dwóch rowerzystów. Próba hamowania i unik na nieistniejące pobocze. Brytyjski bohater zmarł w szpitalu 19 maja. Neurochirurg, który usiłował go ratować, Hugh Cairno, prowadził później przez wiele lat kampanię na rzecz używania kasków motocyklowych. Według wielu – stracił Lawrence’a, ale uratował tysiące motocyklistów.

Jednym ze słynnych klientów był William Lyons. Kupił w 1929 roku model SS 100, a po dwóch latach pojawił się na rynku jego pierwszy samochód sportowy nazwany Swallow SS 100. Dosyć szybko przechrzczono go na Jaguara.

Fabryka w Nottingham obok motocykli budowała wózki boczne, a od 1935 roku samochody sportowe. Tradycyjnie stosowano w nich silniki innych firm takich jak 8-cylindrowy Hudson i 12-cylindrowy Lincoln – Zephyr. Wojna położyła kres działalności. Jeszcze w 1940 roku zbudowano dziesięć motocykli, po czym zajęto się produkcją silników lotniczych Rolls Royce Merlin. Po wojnie nie było dostawców silników i marce nie udało się przetrwać. Motocykle Brough Superior jeszcze przez wiele lat pojawiały się na trasach wyścigów i podczas tygodnia rekordów w Bonneville. Niestety firma już się nie podniosła. SS 80 i SS 100 stały się inspiracją inżynierów i obiektami westchnień kolekcjonerów. George Brough zmarł w 1970 roku.

Legenda powraca

W 90-tą rocznicę powstania legendarnego modelu SS 100 przedstawiono jego współczesną wersję. Prawa do marki kupił w 2000 roku Marc Upham. Jest on postacią znaną od lat w świecie brytyjskich klasyków motocyklowych, jak również w świecie wyścigów. Jako ciekawostkę można podać, że jego firma zajmująca się motocyklami klasycznymi ma siedzibę w Austrii.

Projektem i produkcją nowego Superiora zajęła się francuska firma Boxer Design, kierowana przez Thierry’ego Henriette. Warto wspomnieć, że pracownicy biura projektowego firmy i stylista Sacha Lakic brali udział m.in. w powstaniu francuskiej marki Voxan.

Motocykle projektowano i produkowano we współpracy z zakładami lotniczymi Dessault. Być może nie trafiły w swój czas lub zawiódł marketing, bo marka przez chwilę przestała istnieć. Wykupiona przez Venturi

Automotive przeniosła się do Monaco i zajęła motocyklami elektrycznymi. Zupełnie niedawno zaprezentowała ciekawy motocykl elektryczny o mocy 200 KM i zasiegu 180 km. Ładowanie jego akumulatorów, według zapewnień producenta, trwa nie dłużej niż ładowanie telefonu komórkowego.

Nowy Brough Superior SS 100 zachował styl pierwowzoru. Jest nawet do niego łudząco podobny. Wykorzystano najnowsze technologie, aby zbudować lekką i szybką klasyczną maszynę, godną reprezentowanej marki. W tym celu konstruktorzy musieli odejść nieco od tradycji szacownej firmy.

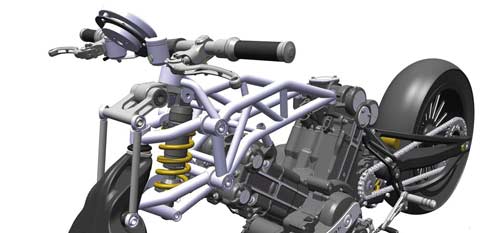

Nie znaleziono producenta silnika, który mógłby być zastosowany w nowej konstrukcji, w związku z czym należało zaprojektować go od podstaw. Wspólnie z firmą Akira Engineering stworzono jednostkę w układzie V rozchyloną o 88 stopni, o pojemności 997 ccm. Założona w projekcie niezwykle niska masa motocykla wymagała specjalnej budowy obudów silnika, ponieważ miał on zostać mocno obciążonym elementem nośnym motocykla. Poza tym zgodnie z tradycją marki miał pozwalać dostosowywać swoje parametry do wymagań klientów. Obecnie sprawa jest prostsza niż kilkadziesiąt lat temu, bo zamiast wyszukanych zabiegów mechanicznych wystarczy pogrzebać w mapach zapłonu. Firma oferuje maszyny o mocy 100 lub 140 KM. Silnik jest częścią bardzo oszczędnej stalowej rurowej ramy połączonej z tzw. subramą wykonaną z tytanu. Wahacz wykonano ze stopu aluminiowo – magnezowego, a za amortyzację odpowiada specjalny, w pełni regulowany produkt firmy Ohlins.

Ciekawie rozwiązano przednie zawieszenie. Powrócono do rozwiązania zastosowanego przez Claude Fiora w wyścigowym motocyklu Yamaha sezonu 1979. Dzięki zabiegom marketingowców wielu zarzuca, że jest to po prostu kopia zawieszenia Duolever BMW. Samo BMW w prospektach reklamowych twierdzi, że skorzystało z rozwiązania brytyjskiego inżyniera Hossacka z 1980 roku. W każdym razie konstruktorzy zawieszenia SS 100 wykonanego z magnezu i aluminium powołują się na Fiora. W układzie hamulcowym zastosowano cztery ceramiczne tarcze.

Motocykl pełen jest typowych dla marki elementów, stanowiących niepowtarzalne „smaczki stylistyczne”. Puryści mogą zarzucić brak klasycznych szprychowych kół. Brak tego klasycznego elementu wynagradza bardzo niska masa motocykla, wynosząca zaledwie 180 kg. Szkoda, że nie ma klasycznych szprych i pięknych gaźników firmy AMAL. Niestety gaźniki uniemożliwiłyby homologację motocykla. Na szczęście nie ma też ABS, kontroli trakcji i innych elektronicznych wynalazków pozbawiających kierowcę przyjemności jazdy klasykiem.

Najnowszy Brough Superior SS 100 to bezsprzecznie dzieło sztuki stylistycznej i inżynierskiej. Maszyna, która już przeszła do motocyklowej klasyki podobnie jak np. mający polskie korzenie Munch Mamuth 2000.

SS 100 zgodnie z tradycją firmy nie będzie tani. W latach trzydziestych jego protoplasta kosztował około dwustu funtów, podczas gdy Triumph Speed Twin około pięćdziesięciu. Obecne ceny rzadkich egzemplarzy SS 100 osiągane na aukcjach przekraczają często pół miliona dolarów.

Ryszard Romanowski

Literatura:

Ian Ward, Laurie Caddell: Great British Bikes, Wyd. Black Cat 1987

Motocykl Moje Hobby

Katalog Brough Superior SS100, 2013

artykuł pochodzi z wydania 7/8 (82/83) lipiec/sierpień 2014

Specjalistyczny portal inżynierski dla osób zaangażowanych w tworzenie produktów – maszyn, urządzeń, mechanizmów, podzespołów, części, elementów itd. – od koncepcji do ostatecznego wykonania.