Wybór redakcji 2012

Słowo „kompozyty” wydaje się mieć dla tego artykułu zbyt szerokie znaczenie. Jest bowiem uniwersalnym określeniem na materiały składające się z więcej niż jednego składnika (faz), które posiadają różne właściwości. A właściwości kompozytów – jak wiadomo – nigdy nie są sumą czy średnią właściwości jego składników.

Marek Bernaciak

Przyjmijmy teraz, że będziemy omawiali klejenie kompozytów opartych głównie na włóknach szklanych, węglowych lub aramidowych przesyconych żywicami poliestrowymi, epoksydowymi lub innymi podobnymi. Kompozyty takie są obecne wokół nas w wielu miejscach, których czasem nawet sobie nie uświadamiamy. Począwszy od nadwozi i kabin samochodów osobowych, autobusów, ciężarówek i naczep z nadwoziami termoizolacyjnymi (chłodni), śmigieł elektrowni wiatrowych, łodzi wyścigowych, elementów architektonicznych i setek innych podzespołów oraz urządzeń. Kompozyty to inaczej chemoutwardzalne tworzywa sztuczne wzmacniane włóknami.

Z klejeniem kompozytów wiąże się pewna anegdota, niestety prawdziwa:

Na jednych z targów w Poznaniu, około 15 lat temu, producent nadwozi izotermicznych wystawił klejoną izotermę, zbudowaną między innymi pod namową moich kolegów z firmy, w której wtedy pracowałem. Właściciel – dumny jak paw ze swojej (słusznej) innowacyjności – powiesił na ciężarówce kartkę z napisem: „Pierwsze w Polsce nadwozie wykonane całkowicie metodą klejenia”. Po dwóch godzinach kartka została zdjęta, gdyż każdy z potencjalnych klientów pytał się zdenerwowanym głosem: „Ale normalne, nitowane nadwozia jeszcze można u was dostać? Bo my się boimy klejonego...”

Dlaczego klejenie kompozytów?

Kompozyty mają wiele zalet, których nie będę szczegółowo omawiał. Jest wśród nich znakomity stosunek sztywności do masy, wytrzymałość mechaniczna, niski ciężar, możliwości formowania itd.

Jeśli chodzi o ich łączenie, napotykamy na pewne utrudnienia. Jest wśród nich obniżona odporność na obciążenia miejscowe. A takie są powodowane przez łączniki mechaniczne. Nawet blachy trudno znoszą np. nitowanie, gdy są narażone na skupione obciążenia od łączników. Kompozyty są w tym obszarze narażone na wyrwania, pęknięcia i najważniejsze dwa niepożądane czynniki:

- Trudność w wykorzystaniu potencjału estetycznego tkwiącego w wykończonych powierzchniach o złożonych kształtach. Ważna jest też aerodynamika i hydrodynamika kształtów, które łatwiej jest wykonać metodą kształtowania elementów kompozytowych i ich klejeniem niż innymi metodami.

- Utrata sztywności elementów oraz potencjału tkwiącego w definiowaniu kształtu elementów kompozytowych.

Innymi słowy – chodzi o estetykę i sztywność konstrukcji. Estetyka to marketing, możliwość zwiększenia sprzedaży. A sztywność to niska masa konstrukcji, czyli niskie koszty materiałowe. Dwa cele wymarzone przez każdego menedżera. Klejenie umożliwia realizację tych dwóch celów jednocześnie. W tym przypadku nie widać zwykłej sprzeczności interesów pomiędzy menedżerami a inżynierami.

Rodzaje złącz

Kompozyty są łączone w kilku podstawowych konfiguracjach:

- Łączenie kompozytów ze sobą – chodzi zwykle o spajanie elementów, które są ukształtowane tak, by dopiero po złączeniu ich powstała konstrukcja spełniająca ostateczne założenia estetyczne i wytrzymałościowe. Często elementy przed sklejeniem są niezwykle wiotkie, trzeba je kleić w specjalnych formach, by utrzymać kształt i wymiary.

- Łączenie kompozytów z konstrukcją nośną, wykonaną najczęściej z profilów stalowych lub aluminiowych – elementy kompozytowe są wtedy najczęściej powłokami ozdobnymi, obudową raczej niż częścią nośną konstrukcji.

- Przyklejanie elementów wykończeniowych - mamy tu do czynienia zarówno z wklejaniem okien, wzierników, ościeżnic, jak i tabliczek,

- Montaż uchwytów i elementów mocujących – przyklejanie usztywnień, śrub ze specjalnym, dużym łbem, zawiasów, haków, zawieszek, zamków, służących do wzmacniania i usztywniania wiotkich konstrukcji, jak pokrywy, powłoki drzwi, klap bagażowych w autobusach, oraz do ich mocowania do konstrukcji nośnej lub z innymi podzespołami.

Z technologicznego punktu widzenia klejenie kompozytów ma istotne słabości, których nie wolno ukrywać. Nie jest to zresztą potrzebne gdyż każdy, kto spróbuje choćby raz skleić coś przemysłowo, napotka na te utrudnienia:

- Klejenie to dodatkowy materiał, zwykle droższy niż materiały rodzime, zwłaszcza jeśli porównać z ceną za kilogram konstrukcji.

- Klejenie to dodatkowa operacja, której należy poświęcić czas technologiczny.

- Trzeba przygotować osobne elementy ustalające i stabilizujące położenie klejonych elementów po złączeniu, albo zastosować dodatkowo automaty składające je w określonym położeniu.

- Sklejone elementy należy przetrzymać w ustaleniu przez określony czas, aż złącze nadawać się będzie do przenoszenia na dalsze stanowiska. Czas ten wymaga pewnego pola odkładczego, a więc zarezerwowaniu czasu, miejsca i kapitału, zarówno na produkcję w toku, jak i na wykonanie odpowiedniej liczby uchwytów, nieraz bardzo specjalistycznych, form lub wózków.

- Niektóre kleje wymagają specjalnego przygotowania powierzchni, usuwania warstwy separatorów, odtłuszczania oraz nanoszenia podkładów. Stanowi to dodatkowy koszt materiałowy oraz dodatkową operację technologiczną.

- Różnica współczynników rozszerzalności cieplnej – jest to zagadnienie, które należy wziąć pod rozwagę w czasie doboru technologii łączenia.

- Po klejeniu czasem należy usunąć wypływki kleju, zwłaszcza jeśli nakładanie jest ręczne, co wiąże się zwykle z nadmiarem i… dodatkowym kosztem kleju, tym razem zupełnie zbędnym z technicznego punktu widzenia. Wypływki mogą stanowić nieraz 30-50% całkowitego zużycia kleju. Czasem po kalkulacji rzeczywistego zużycia kleju i porównaniu go z wymaganym technicznie, okazuje się, że można zaoszczędzić nawet 80% kleju! Takie informacje przynosi nasze doświadczenie.

Dlaczego więc konstruktorzy i technolodzy decydują się na klejenie? I to pomimo braku przygotowania merytorycznego na większości polskich uczelni? Takich powodów jest kilkanaście, tu spróbuję wskazać kilka odnoszących się tylko do łączenia kompozytów.

- Klejenie umożliwia utrzymanie najkorzystniejszego stosunku masy do sztywności. Konstrukcje są coraz lżejsze, przy zachowaniu koniecznej sztywności. To dotyczy większości zastosowań, głównie w transporcie, gdzie masa jest czynnikiem nie tylko w trakcie budowy, projektowania i montażu, ale przede wszystkim w czasie eksploatacji.

- Wspomniany wcześniej aspekt wytrzymałości punktowej – laminaty łatwo jest osłabić przy łączeniu śrubami lub nitami. Klejenie rozkłada obciążenie na większej powierzchni i sprzyja zwiększeniu ogólnej siły przenoszonej przez konstrukcję.

- Szczelność – wiele połączeń w transporcie musi spełniać wymogi szczelności – odporność na wodę, deszcz, mgłę solną, niepożądaną „wentylację” – czyli przeciągi. Klejone złącza spełniają te wymogi niejako przy okazji.

- Łączenie z różnymi materiałami – z metalami, szkłem, innymi tworzywami sztucznymi, a nawet drewnianymi konstrukcjami lub ozdobami byłoby trudne bez klejenia. Mimo różnych współczynników rozszerzalności termicznej różne materiały łączą się skutecznie.

- Estetyka – klejenie umożliwia wykonanie niewidocznych dla laika (a często i dla profesjonalisty) połączeń. Jest to ważne zwłaszcza wtedy, gdy łączone elementy są wykonane „na gotowo”, po klejeniu nie prowadzi się wtedy żadnych operacji zdobiących ani wykończeniowych.

- Odporność na wibracje i zmienne obciążenia – w przypadku konstrukcji transportowych, ale również w przypadku śmigieł elektrowni wiatrowych – odporność na obciążenia udarowe i zmęczeniowe jest kluczowa. Wytrzymałość na wiele milionów cykli jest szczególnie ważna przy konstrukcjach pracujących bez przerwy, jak np. śmigła turbin wiatrowych.

Jak widać, klejenie jest technologią współgrającą z zarządzaniem kosztami, zwłaszcza jeśli chodzi o całkowity koszt posiadania. Jest to, jak Czytelnik doskonale wie (?), sumaryczny koszt związany z posiadaniem przedmiotu lub technologii. Np. na koszt posiadania samochodu ciężarowego składają się nie tylko koszty zakupu, ale też koszty konserwacji, remontów i napraw oraz eksploatacji – jak np. koszt paliwa, koszt tonokilometra, zużycie opon itd., ale najważniejsza jest obciążalność płatna (z ang.: payload), czyli udział masy ładunku w dopuszczalnej masie całkowitej pojazdu.

Jakie kleje do kompozytów?

Jak zawsze, zależy to w dużej mierze od konfiguracji połączenia, miejsca wykorzystania, obciążeń, warunków pracy złącza, temperatur… należy wziąć pod uwagę wiele zmiennych.

Oprócz względów technicznych, należy wziąć pod uwagę zagadnienia technologiczne. Np. kleje metakrylowe są zdecydowanymi faworytami pod tym względem. Pod każdym względem w rzeczy samej.

Kleje metakrylowe są królem łączenia kompozytów i metali. Jednym z ich największych zalet jest możliwość klejenia większości materiałów bez żadnego przygotowania powierzchni. Proszę to potraktować dosłownie: bez żadnego przygotowania – bez chropowacenia, bez odtłuszczania, bez podkładów. Z dużymi prześwitami, przy szczelinach między łączonymi podłożami dochodzących do 50 milimetrów! Kleje metakrylowe posiadają silne właściwości rozpuszczające na prawie wszystkie żywice poliestrowe i żelkoty. Przy tym nie niszczą klejonych elementów, nie powodują nadmiernych prześwitów (śladów w miejscu klejenia wynikających z kurczenia się utwardzającego się kleju). Jako kleje dwuskładnikowe utwardzają się w całej objętości, bez konieczności zostawiania łączonych elementów na kilka dni, by nastąpiła polimeryzacja jak w przypadku jednoskładnikowych klejów poliuretanowych. Złącza charakteryzują się ogromną odpornością na wodę, benzynę i olej napędowy, oraz temperatury do ponad 120 stopni Celsjusza. Są odporne na odchylenia stosunku mieszania, więc proces technologiczny jest dość bezpieczny pod względem zagrożenia brakami.

Wady?

Niestety, mają również wady. I według mnie cena nie jest największą z nich. Tę niedogodność łatwo kompensują mniejsze pola odkładcze, spowodowane krótkim czasem utwardzania złącza.

W dzisiejszych czasach jednak największym utrudnieniem wydają się być... a jakże, przepisy unijne.

Z jakichś, dla mnie niewiadomych powodów, maszyny do dozowania klejów metakrylowych mają spełniać wymogi... antywybuchowe. Niby klej metakrylowy jest palny. Ale wybuchowy? To raczej nie, nawet jego opary, których ilość w procesie klejenia jest marginalna. Oczywiście, biuraliści mają swoje argumenty, ale dla mnie przypominają one zagadnienie krzywizny banana albo definicji marchewki jako owocu. Kto jest beneficjentem tego przepisu, jeszcze nie odkryłem, jednak jeśli chcą Państwo aplikować kleje metakrylowe zgodnie z unijnymi przepisami, należy przygotować dodatkowo minimum 5-9 tysięcy euro, gdyż każda maszyna przy zastosowaniu restrykcyjnych przepisów powinna być atestowana indywidualnie! Oczywiście, zawsze się znajdą tacy, którzy będą bronili przepisów, bo „przecież ktoś to badał i na pewno chciał, żeby było bezpieczniej”, ale zdrowy rozsądek (taka zapomniana dziś cecha ludzi mądrych) mówi: To, co jest na pewno konieczne, to wykonanie całej maszyny i systemu dozującego w stali nierdzewnej, z ewentualnym napędem pneumatycznym. Kleje metakrylowe są bowiem strasznie korozyjne i zamieniają stal, a zwłaszcza metale kolorowe w kupę złomu szybciej niż zdążycie zużyć beczkę kleju.

No i jeszcze zapach… dla niektórych okropny, dla niektórych przyjemny, przypomina gabinet dentystyczny. Jest charakterystyczny, bo metakrylany to pochodne PMMA, czyli szkła organicznego, tworzywa stosowanego w stomatologii do wypełnień, klejenia aparatów stałych i kilku innych aplikacji. Jednak warto pamiętać, że w tym zapachu dentyści spędzają całe życie zawodowe i... nic im nie jest.

Znam przypadki z przemysłu, gdy z powodu zapachu klejów metakrylowych wzywano PIP i Sanepid, prowadzono testy szkodliwości i... eliminowano przy okazji inne produkty chemiczne, które okazywały się bardziej szkodliwe niż pachnący intensywnie metakrylan.

Emisja substancji lotnych – VOC – jest w przypadku klejów metakrylowych i tak znacznie niższa niż w przypadku szpachlówek poliestrowych, gdyż emisja styrenu przy poliestrze jest co najmniej 10-15-krotnie większa.

Poza tym kleje metakrylowe wydają się nie posiadać wad. Są arcytechnologiczne, przyjazne dla inżyniera, tolerują niedbalstwo, prawie nie powodują braków… cudo techniki! Bez żadnej przesady.

W dużym stopniu do klejenia kompozytów stosuje się również szpachlówki poliestrowe. Wypełniona i stiksotropowana żywica jest najczęściej nakładana ręcznie. Ilość szpachlówki musi być znacznie większa niż kleju metakrylowego, ale jej niska cena za kilogram kompensuje tę trudność. Porównanie wytrzymałości, zwłaszcza zmęczeniowej, wypada dla szpachlówek niezbyt korzystnie, ale i tak są w wielu miejscach stosowane. Zwłaszcza tam, gdzie obciążenia jednostkowe są niewielkie. Szpachlówki są kruche, by to wyeliminować wypełnia się je rowingiem, który w naturalny sposób utrudnia znacznie automatyzację procesu mieszania i nakładania. Trudno jest przepompować wężem masę zawierającą np. 60% włókien o długości 50 mm. Dlatego aplikacje klejenia szpachlówką są często prowadzone ręcznie.

Czasem do nakładania zarówno szpachlówek i klejów metakrylowych używa się zwykłych toreb foliowych, które stosuje się jak cukiernicze torby do nakładania kremu na torcie. Jest to prosta i skuteczna metoda, zwłaszcza na początku rozwoju tej technologii w danej firmie.

Kleje elastyczne

Kleje elastyczne stosowane w łączeniu kompozytów to głównie jednoskładnikowe poliuretany i polimery MS.

Są to materiały o wydłużeniu znacznie większym niż 100%, czasem nawet 400-600%. Ten parametr często zwodzi inżynierów, bo wydaje się, że wystarczy nanieść 0,3 mm kleju i... no właśnie. Powinien wydłużyć się do 0,6 mm? Do 2 mm? Obawiam się, że nic z tego. Testy wydłużenia są wykonywane na utwardzonym kawałku kleju (tak zwana „próbka o kształcie kości psa”), o długości ponad kilkudziesięciu milimetrów, więc rozciąga się bez żadnych restrykcji, zupełnie swobodnie może się odkształcać w kierunku poprzecznym do kierunku obciążenia. Tymczasem w złączu klej jest narażony na złożony stan naprężeń.

Jaki z tej wiedzy płynie wniosek? Tak samo jak w technice klejenia metakrylanami, należy zachować pewną minimalną grubość spoiny klejonej. Jednak w klejach elastycznych jest to grubość większa niż dla metakrylanów, powinna wynosić ponad 2-3 mm, nawet 5-6 mm. Przy klejeniu należy więc stosować dystansowanie elementów.

Kleje elastyczne występują często w wersjach jedno- i dwuskładnikowych.

Przy stosowaniu klejów jednoskładnikowych należy pamiętać, że system utwardzania tych klejów polega na reakcji z wilgocią zawartą w powietrzu. Z tego wynikają dwa wnioski:

Klej utwardza się wgłąb, w miarę jak wilgoć wnika w jego strukturę. Dlatego kluczowym parametrem jest szerokość szczeliny, nie jej grubość. Kleje poliuretanowe i polimery MS utwardzają się z szybkością 2-4 mm/dobę. Oznacza to, że szerokie na 20 mm złącze utwardzi się wskroś dopiero po 3-4 dniach i to w optymalnych warunkach. Co prawda już po 24 godzinach można transportować elementy (powierzchniowa skórka ma wstępną wytrzymałość), jednak nawet taki czas oczekiwanie blokuje stanowisko montażowe, uchwyty i halę.

Dlatego coraz częściej producenci przymierzają się do klejów dwuskładnikowych z tej grupy. Utwardzają się one w ciągu godziny, więc czas opuszczenia stanowiska skraca się znacznie. Dlaczego więc nie ma ogólnego, pospolitego ruszenia w tym kierunku? Chodzi o koszt zakupu urządzeń mieszająco-dozujących. Ich cena jest więcej niż dwa razy większa niż systemów jednoskładnikowych. Mimo to, coraz częściej klienci skłaniają się do rozważenia tej właśnie możliwości. Rynek w tej grupie urządzeń rozwija się i coraz więcej firm wkracza również do Polski.

Warto zwrócić uwagę na dwa różne systemy utwardzania klejów dwuskładnikowych. Historycznie pierwszym z nich jest system oparty na tzw. „boosterze”, który dodaje się do kleju w ilości 1-3%, a który nie musi być nawet znakomicie zmieszany, gdyż „booster” tylko przyspiesza polimeryzację, a nie powoduje jej. Bez „boostera” klej również się utwardzi, tylko wolniej.

Co innego kleje z utwardzaczami, zwłaszcza polimery silanowe. W tym wypadku utwardzacz musi być dodany i zmieszany z klejem, w ilości około 10:1 objętościowo – dokładnie. Ponieważ utwardzacz bywa czasem lejny, a czasem pastowaty, wymusza to określone postępowanie w czasie mieszania i nakładania. Kleje takie w obu wersjach pozwalają na przemieszczanie klejonych elementów po około jednej godzinie.

Na polimery MS (polimery silanowe, silanowane, silany – różnie są handlowo nazywane) warto zwrócić uwagę. Na rynek weszły ponad dziesięć lat temu, a ciągle wydaje się, że mało osób zdaje sobie sprawę z ich istnienia. Nieco tylko droższe od poliuretanów, nie wymagają stosowania podkładów, a to jest wielkie ułatwienie i oszczędność. Dodatkowo ciągle dają się malować (jak poliuretany), a niektóre rodzaje wytrzymują nawet procedurę malowania proszkowego (poliuretany zwykle pracują tylko do 90 ˚C). Może dyskusyjna jest ich wytrzymałość zmęczeniowa, ale to nie zawsze ma znaczenie. Oczywiście, nie każdy dostawca prowadzi poważne próby laboratoryjne, nie zawsze otrzyma się pełną informację techniczną. Chciałbym jednak zwrócić uwagę czytelnika na te ciekawe produkty, które uważam są bardzo niedoceniane i nieznane przez inżynierów. Zwłaszcza w obliczu faktu, że kupowane tysiącami są kleje „uniwersalne”, o nieznanym rodowodzie i bez Kart Danych Technicznych, nie posiadające wyników badań laboratoryjnych, bez atestów technicznych, bez podawanych parametrów wytrzymałościowych... Czasem strach jeździć po drodze, nie wiedząc czym są klejone kompozytowe elementy do pojazdów.

Podsumowanie

Klejenie w konstrukcjach kompozytowych z materiałów wzmacnianych włóknem szklanym jest technologią kompatybilną z samą koncepcją kompozytu jako takiego. Jest to technika wzmacniająca konstrukcję, technologiczna i pozwalająca wykorzystać większość korzyści, jakie wiążą się z przyczynami, dla których stosuje się kompozyty w konstrukcjach nośnych.

Marek Bernaciak

AMB Technic

artykuł pochodzi z wydania Listopad 11 (62) 2012

Wydawałoby się, że działalność inżynierska podlega jedynie prawu własności przemysłowej, obejmującemu projekty wynalazcze, patenty, wzory przemysłowe itd. Okazuje się jednak, że działalność ta podlega także prawu autorskiemu, czyli prawu kojarzącemu się raczej z działalnością artystyczną. Przedmiotem tego artykułu jest przybliżenie tematyki prawa autorskiego w działalności inżynierskiej, wskazanie korzyści ze stosowania tego prawa, zarówno dla twórcy – inżyniera, jak i pracodawcy (inwestora), określenie i uniknięcie ewentualnych sytuacji konfliktowych, wynikających z nieznajomości prawa autorskiego.

Aleksander Łukomski

Stosowanie prawa autorskiego może nadać większą rangę grupie inżynierów innowacyjnych, którzy wyróżniają się twórczym podejściem do swojej pracy, poprzez podkreślenie związku autorskiego z utworem (dokumentacją) i ochronę ich działań przed nagminnym, niezgodnym z prawem, wykorzystywaniem w działalności gospodarczej efektów ich pracy. Należy tu zaznaczyć, że ustawodawcy w wielu krajach, także w Polsce, doceniając wpływ działalności twórczej i innowacyjnej na rozwój gospodarki, wydali szereg przepisów promujących taką działalność. Dotyczą one także spraw finansowych i podatkowych. W Polsce, w przypadku umowy przeniesienia praw autorskich, obowiązuje 50% kosztów uzyskania i „zwolnienie z ZUS”. A więc – realne korzyści finansowe dla twórcy.

Zastosowanie prawa autorskiego w działalności inżynierskiej łączy się z pewną specyfiką tej działalności. Próby opisania tego zagadnienia przez prawników nie zawsze docierają do sedna tej specyfiki i w zasadzie dotyczą stosunku twórca techniki – pracodawca. Niniejszy artykuł podejmuje próbę szerszego ujęcia zagadnienia postępowania w twórczej działalności inżynierskiej, poczynając od momentu powstania dzieła do jego ostatecznego wykorzystania. Zawsze jednak, przed podpisywaniem umów, należy przeprowadzić konsultacje z prawnikiem. Najlepiej gdyby był to prawnik specjalizujący się w prawie autorskim. Niestety, o takich prawników jest dosyć trudno.

Zakres stosowania prawa autorskiego obejmuje te dziedziny działalności inżynierskiej, które w zasadzie, przedstawione są w postaci oryginalnej dokumentacji technicznej, sygnowanej podpisem twórcy lub twórców. Dotyczy to: dokumentacji konstrukcyjnej, technologicznej, opisowej, a więc wszelkich projektów, a także szkiców i koncepcji, projektów wstępnych, receptur, instrukcji i wielu innych dokumentacji stosowanych w praktyce inżynierskiej, a posiadających indywidualny, twórczy charakter. Jeżeli dokumentacja np. konstrukcyjna, technologiczna lub inna techniczna jest podpisana przez twórcę to sprawa jest prosta. Podlega ona ochronie z tytułu prawa autorskiego. Trochę gorzej wygląda, gdy powstał prototyp, bez dokumentacji konstrukcyjnej np. maszyna zbudowana systemem majsterskim, ale i ta postać działalności twórczej jest chroniona prawem. Można wtedy posiłkować się dla utrwalenia formy np. dokumentacją fotograficzną, ale nie jest to bezwzględnie wymagane prawem.

Z artykułu wyłączono te dziedziny działalności twórczej, często także inżynierskiej, które są dobrze opisane w innych opracowaniach, takich jak: programy komputerowe, wzornictwo przemysłowe i opracowania naukowe.

Prawo autorskie – podstawowe pojęcia

Prawo autorskie obowiązujące w Polsce od 1994 roku zawarte jest w Ustawie o prawie autorskim i prawach pokrewnych (Dz. U. z 2000 r. nr 80, poz. 904 z póź. zm., tekst jednolity z 2006 r.).

Jest ono od dawna stosowane przez twórców z innych dziedzin, które tradycyjnie uznaje się za działalność twórczą, a więc plastyków, muzyków, pisarzy, filmowców.

Art. 1 ustawy mówi jednak, że dziełem jest każdy przejaw działalności twórczej o indywidualnym charakterze, ustalony w jakiejkolwiek postaci, niezależnie od wartości, przeznaczenia i sposobu wyrażenia. W związku z powyższym przepisem oraz orzecznictwem sądowym dokumentacja techniczna stanowi dzieło (utwór) w rozumieniu prawa autorskiego, pod warunkiem spełnienia przewidzianych prawem cech: indywidualności i oryginalności. Cechy te są znacznie prostsze do spełnienia niż np. wymagana prawem wynalazczym „nieoczywistość” rozwiązania. Znaczy to, że wymagany prawem autorskim poziom twórczości jest bardzo niski, a zatem trudno byłoby wskazać dokumentację techniczną, nie spełniającą wymogów formalnych. Nie stanowią przedmiotu prawa autorskiego: akty normatywne, urzędowe dokumenty, znaki i symbole i opublikowane opisy patentowe i ochronne. Przedmiotem prawa autorskiego są natomiast opracowania cudzego utworu, w szczególności: tłumaczenie, przeróbka, adaptacja, bez uszczerbku dla prawa do utworu pierwotnego. Zgodnie z prawem autorskim ochronie z mocy prawa podlega forma, a nie treść dzieła, która może w tych przypadkach podlegać ochronie z tytułu prawa wynalazczego, nie będącego przedmiotem niniejszego opracowania. Należy zaznaczyć, że twórcza działalność inżynierska może podlegać jednocześnie obu tym prawom. W prawie autorskim mówi się też o „wzorach przemysłowych”, które wymienia się jako podlegające ochronie z tytułu prawa autorskiego. Może to dotyczyć więc, także poza dokumentacjami technicznymi, np. maszyny, urządzenia, przedmiotu zbudowanej, jako prototyp, bez dokumentacji. Wtedy postać jest utrwalona fizycznie w maszynie, czy przedmiocie. Ochronie podlega, poza dokumentacją, postać fizyczna maszyny, urządzenia, przedmiotu.

Ochrona praw autorskich

Z faktu autorstwa płynie dla uprawnionego prawo wyłączne do dzieła.

Prawo to obowiązuje 70 lat po śmierci autora (w niektórych wyjątkach 50 lat) i nie wymaga dla swej ochrony spełnienia żadnych wymogów formalnych, a w szczególności rejestracyjnych. Poza tym, zakres ochrony nie jest ograniczony terytorialnie, w świetle konwencji berneńskiej. Prawo autorskie rozróżnia pojęcia autorskich praw majątkowych, czyli prawo do korzystania z utworu i rozporządzania nim na wszystkich polach eksploatacji, oraz pojęcie autorskich praw osobistych, czyli nieograniczoną w czasie i nie podlegającą zrzeczeniu się lub zbyciu więź twórcy z utworem i obejmującą w szczególności prawo do autorstwa projektu, oznaczania go swoim nazwiskiem lub pseudonimem albo do udostępniania go anonimowo, prawo do nienaruszalności jego treści i formy, decydowania o pierwszym udostępnieniu, oraz prawo do nadzoru nad sposobem korzystania z utworu.

Korzyści i ograniczenia

Przede wszystkim należy tu rozróżnić pojęcia: treść techniczna dokumentacji oraz forma dokumentacji. prawo autorskie chroni formę, czyli sposób przedstawienia określonej treści. Chodzi tu o układ rysunków lub opisu, ich szatę graficzną, kolejność przedstawienia poszczególnych rzutów lub akapitów, wybrany sposób opisu. Nie chroni natomiast technicznej zawartości dokumentacji.

Zamawiający (pracodawca), kupując dokumentację od inżyniera, nabywa techniczną treść zawartą w dokumentacji oraz nośnik (papier, kalka, dyskietka, zapis na serwerze itp.). Jeżeli nie zakupi jednocześnie autorskich praw majątkowych do tej dokumentacji, to zgodnie z ustawą nie wolno mu powielać dokumentacji, przekazać jej podmiotom lub osobom trzecim, nie wolno mu także wprowadzać żadnych zmian w dokumentacji bez zgody autora (tzw. prawa autorskie wtórne). Wynika z tego, że zamawiający może tylko wykorzystać dokumentację do jednego konkretnego celu, na jaki zawarto umowę z twórcą dokumentacji. W praktyce jednak występują sytuacje bardziej skomplikowane, np. producent urządzenia sprzedaje lub w inny sposób przekazuje produkcję innemu producentowi. Jeżeli do tej produkcji potrzebna jest dokumentacja konstrukcyjna i technologiczna nie wolno mu łącznie z przekazaniem produkcji przekazać dokumentacji. Nie można także wnieść dokumentacji jako aportu do spółki. Nie wolno producentowi (pracodawcy) przekazać dokumentacji łącznie z urządzeniem inwestorowi, np. dla potrzeb utrzymania ruchu w zakładzie inwestora. Jest jeszcze inne zagadnienie, niemniej istotne. Zamawiający, nabywając prawa autorskie majątkowe, kupuje jednocześnie gwarancję, że autor nie sprzeda pozostałych egzemplarzy tej dokumentacji innemu, np. konkurencyjnemu producentowi. Może wystąpić cały szereg innych przypadków, tu nie opisanych. Wynika stąd, że obrót dokumentacją techniczną jest ograniczony. Ograniczona jest także ingerencja w dokumentację przez zamawiającego, co w praktyce trudno sobie wyobrazić.

Należy tu zasygnalizować, że przedstawione powyżej przypadki mogą także podlegać ustawie o zwalczaniu nieuczciwej konkurencji i kodeksowi cywilnemu (skutki niewykonania zobowiązań).

Relacje w stosunkach z twórcą

Zgodnie z ustawą, autorskie prawa osobiste pozostają przy twórcy i nie ma on możliwości ich zbycia lub zrzeczenia się. Zbyciu podlegają tylko i wyłącznie autorskie prawa majątkowe. Mogą tu mieć miejsce następujące przypadki:

- umowa zawierana jest bezpośrednio z inżynierem - projektantem, konstruktorem, technologiem organizatorem produkcji itd.,

- umowa zawierana jest z biurem projektów lub firmą inżynierską wykonującą dokumentację,

- umowa zawierana jest z pośrednikiem; sytuacja ta prowadzi do nabycia praw autorskich przez osobę trzecią,

- dokumentacja powstaje w wyniku wykonywania przez pracowników obowiązków pracowniczych (inżynier jest pracownikiem etatowym).

We wszystkich wymienionych przypadkach należy dążyć do zawarcia takich umów, które zawierają odpowiednie postanowienia przenoszące autorskie prawa majątkowe na zamawiającego. Wymaga tego prawo autorskie. Zasada ta dotyczy całego obrotu dokumentacją techniczną, poczynając od pierwszego jej zbycia przez twórcę, do wielokrotnego zbycia przez kolejnych właścicieli. Autorskie prawa majątkowe należą do wartości niematerialnych i prawnych i jako takie podlegają normalnemu obrotowi handlowemu, odpisom amortyzacyjnym itd.

Zawarcie umów, o których mowa powyżej, stwarza szczególną sytuację. Unika się w ten sposób konfliktów zawiłych prawnie, bardzo często trudnych do rozwiązania przez pierwszą instancję sądu. Oczywiście, że w większości przypadków w relacji pomiędzy twórcą a nabywcą dokumentacji nie dochodzi do konfliktów. Działają tu takie czynniki, jak cel umowy oraz zgodny zamiar stron. Należy jednak zdać sobie sprawę z tego, że problemy te narastają w miarę upływu czasu od wejścia w życie ustawy i od wzrostu uświadomienia prawa do ochrony własności intelektualnej twórców. Pamietając przy tym, że większość firm inżynierskich jest firmami prywatnymi, dążącymi do maksymalizacji zysków, że w krajach zachodnich problemy te zostały już dawno rozwiązane, że wreszcie koszt dokumentacji jest wysoki (niekiedy przekracza 10% wartości inwestycji budowlanej, a znacznie więcej, nawet powyżej 30%, w konstrukcjach mechanicznych), należy we wszystkich przypadkach obrotu dokumentacją stosować odpowiednie umowy, dla uniknięcia konfliktów z twórcami, pośrednikami, biurami projektowymi, inwestorami, producentami urządzeń.

Dla przypadku A sytuacja jest najprostsza, istnieją tu dwie możliwości: umowa o dzieło i umowa zlecenie. Zalecana jest umowa o dzieło. Dokumentacja techniczna idealnie odpowiada wymaganiom umowy o dzieło. Może tu wystąpić pewna komplikacja w przypadku, gdy dokumentację tworzy zespół projektantów. Należy wtedy zawrzeć umowy o dzieło z wszystkimi projektantami osobno, z każdym na jego specjalność, np. konstrukcja mechaniczna, instalacja elektryczna, dokumentacja budowlana, technologia, itd. Umowa o dzieło i umowa zlecenia zostały uregulowane w odpowiednich artykułach kodeksu cywilnego.

Dla przypadku B sytuacja przedstawia się następująco: biuro projektów lub firma inżynierska wykonująca na zamówienie innej firmy dokumentację musi najpierw uzyskać prawa autorskie od swoich pracowników. Biuro projektów nie może sprzedać czegoś, czym nie ma prawa dysponować. Osoby opracowujące dokumentację mogą pozostawać z biurem w stosunku pracy lub nie. Jeżeli są pracownikami biura, to jest to opisany poniżej przypadek D. Jeżeli nie są pracownikami biura, to zachodzi przypadek C.

Firma zamawiająca dokumentację w biurze projektów, na podstawie normalnej umowy uzyskała prawo dysponowania dokumentacją techniczną, a więc do produkowania wyrobu i wprowadzania go do obrotu. Nie wolno jej jednak przekazać dokumentacji komukolwiek, nawet kooperantom, kopiować, wprowadzać zmiany, przerysowywać, sprzedać, wnieść do innej firmy jako aport. Dodatkowe problemy mogą powstać po likwidacji firmy, czy prywatyzacji lub fuzji. Aby w pełni dysponować dokumentacją, musi ona nabyć od biura projektów prawa autorskie. Może to być jedna umowa zgodna z kodeksem handlowym, zawierająca dodatkowo odpowiednią treść dotyczącą przeniesienia praw autorskich lub dwie osobne umowy, z których druga dotyczy tylko przeniesienia praw autorskich.

Dla przypadku C sytuacja jest podobna jak dla przypadku B. Pośrednik musi uzyskać prawa autorskie od inżynierów (projektantów, konstruktorów, technologów, itd.), aby przekazać je firmie zamawiającej u niego dokumentację.

Dla przypadku D sytuacja jest w zasadzie omówiona w ustawie. Zgodnie z art. 12 ustawy, pracodawca uzyskuje majątkowe prawa autorskie do utworów stworzonych przez swego pracownika, w wyniku wykonywania przez niego obowiązków ze stosunku pracy, z chwilą przyjęcia dzieła – w granicach wynikających z celu umowy o pracę i zgodnego zamiaru stron, o ile ustawa lub umowa o pracę nie stanowi inaczej. Twórcy pozostają w tym jedynym przypadku tylko autorskie prawa osobiste.

Zapis art. 12 jest niby jednoznaczny. Jednak inne artykuły tej ustawy, jak również komentarze wielu prawników zajmujących się tą tematyką nie są tak jednoznaczne.

Dotyczy to zwłaszcza takich terminów, jak: „umowa o pracę”, czy „stosunek pracy”, które nie są jednoznaczne i mogą budzić wątpliwości. Nabycie przez pracodawcę autorskich praw majątkowych wymaga spełnienia pewnych określonych ustawą warunków np. musi mieć formę pisemną. Spełnienie tych warunków może budzić wątpliwości. W związku z tym sugeruje się zawieranie odpowiednich umów z pracownikami. Umowa, o której mowa, powinna być zawarta poza normalną, standardową umową o pracę. Zgodnie z ustawą nie można jednak nabyć praw autorskich do utworów, które powstaną w przyszłości, których obecnie nie ma. W związku z tym w umowie muszą znaleźć się odpowiednie sformułowania. Sugeruje się zawarcie aneksu do umowy o pracę. Aneks ten może być zawarty każdorazowo, kiedy występuje taka potrzeba. Inżynier w zakładzie pracy nie zawsze wykonuje pracę twórczą. Możliwe jest również każdorazowo zawarcie umowy przez pracodawcę i pracownika lub pracowników o sprzedaży autorskich praw majątkowych do każdego projektu za stosowną zapłatą. Dla spełnienia innych artykułów ustawy należałoby także wystawić arkusz założeń projektowych dla każdego projektu oraz, po zakończeniu pracy projektowej, protokół odbioru (przyjęcia dzieła) przez pracodawcę. Ostatni dokument należy wystawiać w każdym przypadku, przy innego typu umowach także, przy umowach o dzieło i umowach zlecenia.

Jak wynika z powyżej opisanych przypadków stosowanie prawa autorskiego może wydawać się trudne w praktyce inżynierskiej, jednak ze względu na „korzyści” warto podjąć trud przetarcia tej ścieżki. Wiele instytucji jak np. instytuty lub ośrodki badawczo–rozwojowe czy biura projektów z powodzeniem stosują już przepisy prawa autorskiego praktycznie. Również w fabrykach można je stosować, w obrocie dokumentacją techniczną, czy własnością przemysłową.

Ramy artykułu nie pozwalają na omówienie wszystkich aspektów tak szerokiego zagadnienia jak prawo autorskie wraz z odpowiednimi przypisami, wyrokami sądów, opracowaniami prawników. Należy więc powiększyć wiedzę na ten temat, zaangażować odpowiedniego prawnika. Pomocne może być też, w trudnych przypadkach, zwrócenie się do np. Politechniki Świętokrzyskiej w Kielcach, która specjalizuje się w przedstawionych w artykule sprawach prawa autorskiego w działalności inżynierskiej.

Aleksander Łukomski

Podczas pikników i wystaw lotniczych zawsze wypatruje się polskich konstrukcji. Pozostało to być może z czasów gdy byliśmy lotniczą potęgą, a nasze statki powietrzne wygrywały najznamienitsze, światowe zawody. Polacy byli dumni z konstruktorów, pracowników przemysłu lotniczego i oczywiście pilotów. Gazety zamieszczały relacje na pierwszych stronach.

Ryszard Romanowski Ryszard KędziaPiloci i konstruktorzy byli czasem nawet bardziej znani niż gwiazdy scen i politycy. Wszystkich rozpierała duma, że kraj, który niedawno powrócił na mapy, może poszczycić się wielkimi osiągnięciami w najbardziej wyszukanej technologii. Wiele z tego zachowało się nawet w PRL. Produkowaliśmy samoloty na licencji radzieckiej, często znacznie je udoskonalając. Powstawały też rodzime konstrukcje. Przykładem mogą być szybowce. Szkoła genialnego Antoniego Kocjana jest kontynuowana do dzisiaj. Często zdarzało się, że mistrzostwa świata zdominowane były przez maszyny polskiej konstrukcji. Za ich sterami można było znaleźć najlepszych pilotów z całego świata.

Ryszard KędziaPiloci i konstruktorzy byli czasem nawet bardziej znani niż gwiazdy scen i politycy. Wszystkich rozpierała duma, że kraj, który niedawno powrócił na mapy, może poszczycić się wielkimi osiągnięciami w najbardziej wyszukanej technologii. Wiele z tego zachowało się nawet w PRL. Produkowaliśmy samoloty na licencji radzieckiej, często znacznie je udoskonalając. Powstawały też rodzime konstrukcje. Przykładem mogą być szybowce. Szkoła genialnego Antoniego Kocjana jest kontynuowana do dzisiaj. Często zdarzało się, że mistrzostwa świata zdominowane były przez maszyny polskiej konstrukcji. Za ich sterami można było znaleźć najlepszych pilotów z całego świata.

Nie mogąc, z przyczyn politycznych, budować dużych samolotów, skoncentrowaliśmy się na tych mniejszych. Niewielu zapewne pamięta, ze w czasach PRL byliśmy drugim producentem samolotów rolniczych na świecie. Nadal piloci i konstruktorzy gościli w radiu, przed kamerami TVP i w gazetach codziennych, nie wspominając o periodykach lotniczych i modelarskich. Oczywiście odgórne instrukcje, realizowane przez redaktorów naczelnych, wynikały z pobudek nieco innych niż przed wojną.

| W lipcu 1967 roku Jarosław Janowski przyszedł do stolarza z Aeroklubu z rysunkami i oświadczył, że będzie robić samolot. Tak rozpoczęła się, słynna chociażby z filmu „Wysokie loty”, nakręconego w 1978 roku, historia J1 „Prząśniczki”. Był to pierwszy lekki samolot zbudowany w PRL oraz pierwszy samolot prywatny. Po siedmiu latach „walki” z ówczesnymi władzami lotniczymi o zgodę na użytkowanie, został on wpisany do rejestru statków powietrznych pod znakami SP–0002. Kolejne konstrukcje to J2 „Polonez”, J3 „Orzeł” i J4 „Solidarność”. Na bazie doświadczeń przy ich budowie powstał całkowicie kompozytowy J5 „Marco”. Pod koniec 1991 roku Jarosław Janowski wraz z Januarym Romanem założyli firmę J&AS Aero Design sp. z o. o. Początek 1992 to intensywne prace nad nowym modelem J6 „Fregata”. Prototyp zarejestrowano 24 stycznia 1994 roku. W roku 2003 koncern BAE Systems wybrał konstrukcję Janowskiego na bazę samolotów bezzałogowych. HERTI-1B to pierwszy samolot bezzałogowy, który uzyskał prawo do autonomicznych lotów w powietrznej przestrzeni kontrolowanej Królestwa Wielkiej Brytanii. Zgodę polskich władz na użytkowanie motoszybowca J6 „Fregata” przez pilotów „nieoblatywaczy” uzyskano jesienią 2010 roku. Od zarejestrowania prototypu minęło niemal 16 lat. źródło: Motoszybowce Kwartalnik Lotniczy, 1/2012 |

Tym, nieco może przydługim, wstępem, chciałem oddać myśli kłębiące się w głowie wychowanka dawnych modelarni lotniczych Aeroklubu Polskiego na widok motoszybowca J 6 Fregata „zaparkowanego” na lądowisku w Trzebiczu Nowym. Konstrukcja Jarosława Janowskiego, legendarnego twórcy „Prząśniczki” przypominała mi ponadto brytyjskie bezpilotowe statki powietrzne czyli UAV, których zdjęcia przeglądałem, pisząc tekst do poprzedniego numeru. Fregatę ustawiał na lądowisku wiceprezes zarządu J & AS Aero Design, jak również Polskiego Stowarzyszenia Motoszybowcowego inżynier Ryszard Kędzia.

– Jak wyglądała droga od „Prząśniczki” do „Fregaty” i ewolucja pomysłów Jarosława Janowskiego?

– Droga przez mękę. Janowski to taki człowiek, który poświęca się dla jakiejś idei. W tym wypadku idei budowy statków powietrznych dla edukacji, dla turystyki lotniczej – swobodnego latania. Stąd jego droga do coraz lepszych konstrukcji, coraz doskonalszych technicznie, a zarazem bezpiecznych. Logicznym następstwem dawnych pomysłów był wybór statku powietrznego takiego jak motoszybowiec, na którym bez silnika można sobie np. spokojnie wylądować.

– Czym charakteryzuje się motoszybowiec i czym różni od samolotu ultralekkiego?

– Sytuacja w takim państwie jak nasze, gdzie dominuje prawo europejskie, zmusza do przewartościowania pojęć, w tym definicji motoszybowca. Jest on innej kategorii szybowcem, z silnikiem zabudowanym na stałe, nie chowanym podwoziem i stałym śmigłem, czyli jest to szybowiec charakteryzujący się tym, że ma na stałe zabudowane mechanizmy napędowe i nie chowane podwozie.

– Czy można zaryzykować twierdzenie, że jest to statek powietrzny łączący zalety szybowca i samolotu?

– Zasadniczo jest to szybowiec, ale dzisiejsza technika i technologia pozwalają na zbliżenie się do parametrów bardzo samolotowych, takich jak duża prędkość i manewrowość, przy zachowaniu cech szybowcowych, czyli stosunkowo dużej doskonałości, pomiędzy 20 a 30 (z 1 km wysokości możemy przelecieć na odległość 20 do 30 km). Dlatego np. niemieckie firmy ubezpieczeniowe najniżej ubezpieczają motoszybowce. Wynosi to około 1/3 sumy żądanej przez polskie ubezpieczalnie, które nie rozróżniają statków powietrznych. Dla nich wszystkie są samolotami. Samoloty mają doskonałość 7 do 10, czyli gdy silnik ulegnie awarii mają znacznie mniej czasu na odnalezienie lądowiska. Mają też inną konfigurację lądowania. W sytuacjach awaryjnych często kończy się kapotażem, czyli przewróceniem samolotu na plecy, ze względu m.in. na wysoko umieszczony środek ciężkości.

Motoszybowiec jest idealny do dalekiej turystyki i edukacji. Młody szkolący się człowiek właśnie w nim może wykazać się umiejętnościami. W przypadku dwuosobowych samolotów szkolnych nie wiadomo, tak naprawdę, kto prowadzi. W motoszybowcu adept jest sam. W przypadku gdy nastąpi np. awaria napędu, ma szansę na bezpieczne lądowanie w tzw. terenie przygodnym. Szybowiec to jedyny statek powietrzny, który ma zgodę na lądowanie w terenie przygodnym, a motoszybowiec mieści się w kategorii szybowców. Lądowanie w terenie przygodnym nie jest traktowane jako incydent lotniczy, który każdy praworządny obywatel, na mocy ustawy, ma obowiązek zgłosić władzom.

– Jak to jest, że w Polsce „Fregata” brnie przez urzędowe bariery, a w Anglii już dawno lata w wersji bezzałogowej?

– Pan Janowski na bazie ponad 30-letnich doświadczeń, mając wielką wiedzę i praktykę, rozumiejąc także swoje możliwości, podjął się zbudowania motoszybowca, który wyprzedził na wiele, wiele lat inne konstrukcje. Warto przypomnieć, że pomysł zrodził się w 1992 roku, a pierwsze loty przeprowadzono w roku 1994.

Urząd lotnictwa nie potrafił odpowiednio zakwalifikować tak nowatorskiej konstrukcji, mimo że na bazie płatowca powstały co najmniej dwie prace doktorskie udowadniające stabilność konstrukcji. Później, historia, a szczególnie doświadczenia Brytyjczyków z British Aerospace Electronics Systems, pokazały, że jest to statek bardzo stabilny w locie i dający ogromne możliwości. Janowski konstruował go na 400 kg masy startowej, a BAES podaje 750 kg! Samolot startuje wtedy przy 140 km/h, bo jest tak ciężki, ale startuje i leci. Wykonuje misję 24-godzinną na wysokości 11000 m. Jest to dowód na to, jak konstrukcja jest doskonała. BAES jest producentem samolotów i drugim producentem uzbrojenia na świecie, po Lockheed Martin. Szukali gotowego rozwiązania.

HERTI to skrót od High Endurance Rapid Technology, czyli szybkiego wykorzystania istniejących rozwiązań technicznych o wysokich parametrach. Anglicy nie chcieli tracić czasu na opracowanie własnego rozwiązania i wyszukali poprzednią konstrukcję Janowskiego J5. To również ciekawa historia, bo początkowo był to samolot ultralekki. Dorobiono dłuższe skrzydła i okazało się, że może znaleźć się w kategorii motoszybowców. Powstało około trzydziestu sztuk J5 i Anglicy jakoś je odnaleźli. Kiedy zaproponowali, że chcą tę konstrukcję kupić, Janowski odpowiedział, że już jej nie produkuje, bo ma lepszy model. Wykonali próby i okazało się, że rzeczywiście nie ma po co wracać do J5.

BAE Systems HERTI

Warto wspomnieć, że J5 miał pobite cztery rekordy świata w kategorii CA1, statków powietrznych do 300 kg. Pobił je były francuski kierowca wyścigowy, znany z Le Mans, Alain Flotard. Jeden z rekordów szybkości bity był na prestiżowej trasie Paryż–Londyn.

– Czy „Fregatą” nie było zainteresowane nasze wojsko?

– Motoszybowiec brał udział w przetargu, ale wybrano konstrukcję izraelską. Wydano miliony euro. Producent nie dostarczył programu i samoloty do dzisiaj nie wzniosły się w powietrze. Gdyby nagle teraz coś się diametralnie zmieniło to powrót do „Fregat” jest już zupełnie nierealny, bo Anglicy mają wyłączność na zastosowania militarne tego samolotu.

– Trudno to nawet określić w sposób cenzuralny. Zmieńmy na chwilę ponury nastrój rozmowy i przejdźmy do rozwiązań technicznych J6.

– Napęd stanowi silnik motorowodny, z tej prostej przyczyny, że silniki motorowodne muszą spełniać bardzo wyśrubowane kryteria bezpieczeństwa. Gdy jacht wypłynie w morze to również musi wrócić. Japończycy ten silnik wyprodukowali w 2007 roku, w milionowym egzemplarzu. Są to silniki dopracowane maksymalnie, tak jak to jest możliwe, budowane w ogromnych seriach. W lotnictwie nie ma tak dużych serii. Silnik jest niezwykle oszczędny, systemy sterowania są niezawodne i proste. „Fregatą”, na sześćdziesięciu litrach paliwa, które można zmieścić w skrzydłach, da się przelecieć około 2000 km. Nie występuje kwestia braku paliwa. Jeżeli ktoś wystartuje rano to u schyłku dnia wyląduje z paliwem, bez konieczności tankowania gdzieś po drodze.

– Jest to spełnienie marzeń o swobodnym lataniu. Bezpieczny motoszybowiec, otwarte niebo i konstrukcje ułatwiające latanie nawet zupełnym amatorom.

– Tak. Dwa lata temu, minister transportu podpisał rozporządzenie zgodne z prawodawstwem europejskim o swobodnym lataniu. Nie mówi się w nim konkretnie o swobodnym lataniu, ale rozporządzenie reguluje sprawę wykonywania lotów w strefie Schengen bez składania planu lotu. Oznacza to, że takim samolotem w strefie Schengen, jeżeli będę leciał w strefie G, czyli wolnych lotów, to nie muszę składać ani planu lotu, ani opowiadać się służbom. Po prostu nie naruszam niczyich interesów i chcę aby uszanowano moją wolność latania. Gdybyśmy w samolocie założyli tzw. EFIS, czyli elektroniczny system instrumentów lotu, to na karcie pamięci możemy nagrać cały profil lotu np. ucznia. Na ziemi korzystając z laptopa wyposażonego w stosowny program możemy profil nałożyć na mapę google i dokładnie wszystko przeanalizować. Teraz mamy ileś zegarów, a tam tylko jeden ekran, który je zastępuje. Najnowsza Cesna 162 w ogóle nie ma już mechanicznych przyrządów. Amerykańskie prawo to dopuściło, uznając że elektronika jest już co najmniej tak niezawodna w działaniu jak zegary analogowe. Dochodzą do tego systemy nawigacji satelitarnej, których awaria lub wyłączenie nam nie grozi. Mamy bowiem do dyspozycji GPS, rosyjski Glonass, a za chwilę europejski Galileo.

Nie ma możliwości aby wszystkie na raz przestały działać. Dlatego też Niemcy po cichu pracują nad tzw. systemem wspomagania pilota. Na czym to mniej więcej polega? Wiadomo, że najtrudniejszy jest start i lądowanie. Niemcy pracują nad systemem, który automatycznie startuje i ląduje, a jak ktoś się zdrzemnie na długiej trasie to też poprowadzi. Można zobaczyć w internecie, na stronie firmy Steme, lądowanie automatyczne, z kamery umieszczonej na motoszybowcu. Pilot tak nie wyląduje, bo automatyka działa dużo precyzyjniej i szybciej niż najlepszy pilot. Znany nam GPS pozycjonuje z dokładnością do kilku metrów, a w naszym kraju zbudowano w ramach projektów unijnych 52 stacje poprawkowe, które dają dokładność 15 cm. Maszyny rolnicze z dobrze ustawionymi odbiornikami mogą obrabiać rośliny z dokładnością do 1 cm, co więc możemy powiedzieć o samolotach? Wylądowanie w danym punkcie nie jest żadnym problemem technicznym. Tyle, że jak to w lotnictwie, jest biurokracja, cicha walka o to, kto ma te produkty sprzedawać. Szczególnie w Polsce biurokracja próbuje blokować wszystko… szkoda mówić. To, co się dzieje w Urzędzie Lotnictwa Cywilnego, jest delikatnie mówiąc, karygodne.

– Zauważyłem, że „Fregata”, przy której rozmawiamy, zamiast przylecieć, przyjechała na przyczepie. Dlaczego?

– Ten samolocik czeka już prawie rok na rejestrację. W lutym były złożone dokumenty, czekaliśmy do czerwca, aby urzędnik powiedział, że nie było pisma przewodniego, w którym wnosimy o to, aby uruchomił proces certyfikacji. Tłumaczymy, że nie było takich wymogów, na co słyszymy ripostę urzędnika, że przepis wprowadzono w marcu.

Urzędnicy mają na biurkach kartki z upływającymi terminami spraw do załatwienia. Gdy mija trzydzieści dni wystarczy napisać cokolwiek, aby zyskać nowe trzydzieści dni. Ostatnio kolega z USA zjawił się w urzędzie z licencją. Usłyszał, że przepisanie nastąpi od ręki. Faktycznie, wszystko na jego oczach wypełniono i napisano. Po odbiór zgłosi się pan za trzydzieści dni – usłyszał – ale jak pan zapłaci 150 czy 300 zł, to już za siedem dni będzie do odebrania. Jak to się nazywa ?

– Jest aż tak tragicznie?

– Opowiem coś jeszcze lepszego. Wydrukowałem, i dobrze, bo nie ma już tego w zasobach internetu. Chodzi o nowe opłaty wymyślone przez urzędników Urzędu Lotnictwa Cywilnego, które wzrosły 5-, 10-, 20-, a nawet 100-krotnie. Chcieli, aby wprowadziła je ustawa. Pozwolenie na produkcję tzw. wyrobu lotniczego miało wzrosnąć z 400 zł do 40 tysięcy zł! Zamordowaliby wszystkich producentów lotniczych w Polsce. Teraz wypierają się tego, ale na szczęście wydrukowałem. Twierdzą, że oni tego nie wymyślili, bo było polecenie. Nie mówią jednak czyje. Drastyczne zwiększenie opłat dla polskich producentów nie może być przypadkowe. Zadziałano na zasadzie, że może się uda.

Prezes ULC obruszył się na moją wypowiedź, że rok czekaliśmy na zbadanie zawartości CO w kabinie. Tłumaczył, że powinniśmy rozumieć, że to dla bezpieczeństwa itd. Mówił, że to nieprawda, iż badanie trwało rok. Oczywiście, trwało jeden dzień, ale rok czekaliśmy na to, aby to badanie przeprowadzili. W lecie przyjechał urzędnik w dresie, zapytał, gdzie kawiarnia, m.in. wypił kawę, po czym wyjął instrument badawczy. Coś takiego jak wiesza się w łazience koło bojlera... Zażyczył sobie obiadu, wykazując całkowity brak zainteresowania samolotem. Zapytany o wyniki stwierdził, że zapisze je później. Po takich i podobnych wizytach można odnieść wrażenie, że urzędnicy mają działać tak, aby nic się nie udało.

– Słyszałem o kolejnych pomysłach, szczególnie o podobnym do „Fregaty” motoszybowcu dwuosobowym?

– Dzisiaj nie może już powstać taka konstrukcja jak J6. Janowski nie zdążył skończyć politechniki podobnie jak Antoni Kocjan, nasz patron, chociaż był powszechnie nazywany inżynierem i był człowiekiem ogromnej wiedzy. Uczył się samodzielnie i dał dowód na to, że można przeprowadzić skutecznie taki proces edukacji. Dzisiaj, kiedy w UE obowiązują zasady wymagające, że aby statek powietrzny mógł być zaakceptowany przez władze lotnicze, jego projekt musi być zrealizowany za pomocą certyfikowanego programu projektowego (który wyliczy wszystkie węzły, obciążenia itd.), przez certyfikowaną jednostkę projektującą. Sam program kosztuje prawie 200 tysięcy zł, praca trwa około 200 godzin, czyli trzeba zapłacić za nią około 300 tysięcy zł. Mamy już pół miliona tylko na sam pomysł. To wszystko idzie do organizacji europejskiej, która dzięki temu, że program i biuro były certyfikowane, nie czuje się aż tak odpowiedzialna za sprawy konstrukcyjne. Zleca więc łaskawie naszemu Urzędowi Lotnictwa Cywilnego nadzór nad budową tego statku. Wykorzystując programy komputerowe możemy wykonać formy. Mając formy wykonujemy pierwszy egzemplarz, który cały czas nadzorowany jest przez władzę krajową, na zlecenie europejskiej agencji. Powstaje statek powietrzny, który musi przejść wszystkie próby. Gdy przejdzie je pozytywnie, dostaje akceptację EAI. Wtedy możemy myśleć o tzw. certyfikacie. W Polsce średnio oczekuje się na certyfikat od pięciu do siedmiu lat. W kwietniu zeszłego roku na targach w Friedrichshafen Niemiec pokazał podobny motoszybowiec z napędem elektrycznym tzw. „Electra 1” niewykończony i bez certyfikatu. Już w październiku odbył się pierwszy lot i w następnym roku na targach statek posiadał certyfikat. Wszystko to trwało kilka miesięcy. Tak to działa. Niemcy są w federacji i są krajem poważnym, w którym urzędnik jest po to, aby załatwić sprawę, a nie po to, żeby urzędować.

– Jak to wygląda w innych, nowych krajach Unii? Większość samolotów wokół nas nosi czeskie znaki OK, bo u naszych południowych sąsiadów jest znacznie taniej. Sam prezes Aeroklubu Polskiego również lata na czeskich znakach. Niedługo litery SP staną się rzadkością.

Proszę spojrzeć na stojące obok Pipistrele, to jest młoda firma słoweńska. Latają na nich Polacy, więc mają znaki OK. Jak zrobiła się transformacja, to praktyczny czeski naród postanowił zrobić takie małe Niemcy. Jak Niemcy zrobili swoją lustrację, to Czesi przeprowadzili swoją tak samo. Niemcy małe samoloty oddzielili od lotnictwa cywilnego, Czesi również powołali oddzielną organizację. Teraz są trzecim producentem na świecie. Troszeczkę podobnie było w Słowenii i dlatego słoweńskie produkty sprzedawane są w całym świecie. Pipistrel zakłada fabryki w USA. Budując wersję dwuosobową motoszybowca Słoweńcy postąpili podobnie do pomysłu Janowskiego. Połączyli dwa kadłuby skrzydłem środkowym, następnie szybko i bez większych problemów uzyskali certyfikat.

– Dziękuję bardzo za rozmowę.

Rozmawiał:

Ryszard Romanowski

zdjęcia: autor

i BAE Systems

artykuł pochodzi z wydania Wrzesień 9 (60) 2012

Wpływ rodzajów zastosowanych mechanizmów rozdziału mocy w pojeździe na jego ruch jest dostrzegany przez większość użytkowników bardzo rzadko, jedynie w szczególnie trudnych i granicznych warunkach ruchu i to tylko przez kierowców o większej świadomości działania układów napędowych. Znaczenie tych mechanizmów szczególnie uwidacznia się w przypadkach, kiedy siły przyczepności poszczególnych kół napędowych znacznie się różnią lub niektóre koła całkowicie straciły kontakt z nawierzchnią (rys. 1). Stąd przekonanie o ważności zagadnień rozdziału momentów napędowych na koła i wynikających z tego właściwości napędowych pojazdu mają konstruktorzy i użytkownicy samochodów terenowych, sportowych i różnego rodzaju kołowych maszyn roboczych, w których trzeba rozwinąć maksymalne siły napędowe w różnorodnych i najczęściej trudnych warunkach eksploatacji.

Jan Dzida

Konieczność stosowania mechanizmów lub bardziej rozbudowanych systemów rozdziału mocy wynika również z niezmiennej, ugruntowanej kilkadziesiąt lat temu, ogólnej koncepcji pojazdów silnikowych. Jej charakterystyczną cechą jest jedno źródło napędu – silnik spalinowy i kilka kół napędzanych, najczęściej dwa lub cztery.

Rys. 1

Jak długo taka koncepcja budowy pojazdów będzie się utrzymywała, tak długo mechanizmy lub systemy rozdziału mocy będą niezbędne. Dopiero w pojazdach o kołach indywidualnie napędzanych odrębnymi silnikami, na przykład elektrycznymi, mechanizmy rozdziału mocy nie będą potrzebne i może je zastąpić centralny moduł elektroniczny sterujący mocami doprowadzanymi do poszczególnych kół. Jednak czy taka koncepcja napędzania kół pojazdów upowszechni się, trudno w tej chwili przewidywać, gdyż będzie to zależało od wielu, zmiennych w czasie, czynników techniczno-ekonomicznych.

Tabela 1 przedstawia autorską klasyfikację mechanizmów i systemów rozdziału mocy [10], w której głównym kryterium jest stopień realizacji rosnących oczekiwań oraz, w pewnym stopniu, chronologia ich powstania.

Tabela 1 Grupy konstrukcyjne

mechanizmów i systemów

rozdziału mocy

Najszerzej wykorzystywaną grupą są mechanizmy różnicowe, które najczęściej mają postać stożkowej planetarnej przekładni zębatej. Zostały one wprowadzone do pojazdów silnikowych ponad sto lat temu i w początkowym okresie można było uznać je za znaczące osiągnięcie w stosunku do rozwiązań ze sprzęgłami jednokierunkowymi, czy też napędem tylko jednego koła danej osi. Szybko jednak zorientowano się, że takie mechanizmy różnicowe mają pewne wady, a główna z nich – to spadek siły napędowej obydwu kół mostu napędowego, już gdy jedno z nich ma zmniejszoną siłę przyczepności. Aby wyeliminować tę wadę zaczęto rozwijać konstrukcje mechanizmów w dwóch głównych kierunkach. Pierwszy z nich to stosowanie różnego rodzaju kształtowych sprzęgieł blokujących (tak zwanych blokad), które okresowo wyłączają z pracy mechanizm różnicowy, drugi – polega na powiększaniu tarcia wewnętrznego w mechanizmie przez stosowanie specjalnych przekładni krzywkowych lub ślimakowych, albo dodatkowych sprzęgieł ciernych (ta podgrupa jest wyróżniona w tabeli 1). Przegląd specjalnych mechanizmów różnicowych podnoszących właściwości napędowe pojazdów można znaleźć w wielu podstawowych pozycjach literatury (np. [4], [14], [16], [17]). W miarę upływu lat coraz bardziej wzrastała świadomość tego, że duża wartość momentu tarcia w mechanizmie różnicowym powinna występować jedynie krótkotrwale w najtrudniejszych warunkach ruchu, zaś w pozostałych moment ten powinien być jak najmniejszy, gdyż pogarsza kierowalność samochodu i sprawność przeniesienia napędu. W wyniku takiego podejścia wielu producentów, wykorzystując coraz nowocześniejsze technologie, zaczęło opracowywać nowe typy mechanizmów różnicowych o powiększonym momencie tarcia wewnętrznego, których działanie jest lepiej dopasowane do chwilowych warunków ruchu pojazdu. Ten nurt rozwoju i badań mechanizmów różnicowych podjął również autor niniejszego opracowania.

W cyklu artykułów zostaną przedstawione fragmenty wieloletnich prac badawczych obejmujących kompleksowe i oryginalne podejście do problematyki rozdziału mocy w pojazdach. W pracach tych realizowano sformułowaną tezę, że jest możliwe zbudowanie nowych mechanizmów rozdziału mocy ze zintegrowanymi regulatorami ich działania, reagującymi na wymuszenia kinematyczne. Tezę tę potwierdzono przez wykonanie i przebadanie wielu typów mechanizmów o nowych zasadach działania, przeznaczonych do różnych pojazdów. Idea nowych mechanizmów oraz większość konstrukcji, prototypów i ich badań zostały opracowane i wykonane w Instytucie Technologiczno-Samochodowym Filii Politechniki Łódzkiej w Bielsku Białej.

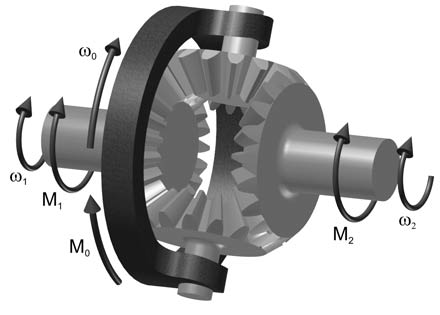

Rys. 2 Schemat symetrycznego stożkowego mechanizmu różnicowego

Aktualnie, na skutek utworzenia w 2001 r. nowej uczelni i związanych z tym zmian organizacyjnych, autor kontynuuje tę tematykę w Katedrze Silników Spalinowych i Pojazdów na Wydziale Budowy Maszyn i Informatyki Akademii Techniczno-Humanistycznej w Bielsku-Białej. Wykonanie prac badawczych o tak dużym zakresie nie byłoby możliwe bez wywołania zainteresowania i nawiązania współpracy z wieloma firmami motoryzacyjnymi oraz ośrodkami badawczymi krajowymi i zagranicznymi. Do najważniejszych należy zaliczyć współpracę z: Fabryką Samochodów Rolniczych w Poznaniu (opracowania do polskiego samochodu terenowego Honker), Wojskowym Instytutem Techniki Pancernej i Samochodowej w Sulejówku, Fabryką Samochodów Osobowych w Warszawie, Ośrodkiem Badawczo-Rozwojowym Samochodów Małolitrażowych BOSMAL w Bielsku-Białej oraz w części tematyki z Centro Recerche FIAT w Orbassano. Dzięki partnerstwu tych firm oraz wsparciu Komitetu Badań Naukowych w Warszawie możliwe były szerokie prace nad zespołami napędowymi o nowych koncepcjach działania.

Ideą tych rozwiązań jest wykorzystanie parametrów kinematycznych, dostępnych w obrębie mechanizmu różnicowego (które niosą informacje o współpracy kół napędowych z jezdnią), oraz – co szczególnie ważne – wykorzystanie rozwiązań mechanicznych do realizacji zaawansowanych funkcji regulacyjnych, które dzisiaj uważa się za możliwe do wykonania jedynie przez systemy elektroniczno-elektryczne, elektroniczno-hydrauliczne lub podobne. W założeniu, końcowym wynikiem prac ma być zbudowanie stosunkowo prostych mechanizmów różnicowych z mechanicznymi układami regulacji, które będą konkurencyjne względem typowych współczesnych rozwiązań, opartych na standardowych elementach automatycznego sterowania.

Kinematyka i dynamika mechanizmu różnicowego

Aby wgłębić się w tematykę rozdziału mocy na koła wydaje się celowe przybliżenie podstawowych właściwości najprostszego mechanizmu różnicowego. Mechanizm taki, dodatkowo określany jako symetryczny, najczęściej stosowany jest w mostach napędowych pojazdów (rys. 2 – na poprzedniej stronie). Poniżej zostaną przedstawione elementarne zależności kinematyczne i dynamiczne takiego mechanizmu. Zrozumienie tych prostych zależności ułatwia również analizę i porównywanie konstrukcji bardziej zaawansowanych.

Warunkiem symetryczności mechanizmu są jednakowe koła koronowe osadzone na wałach wyjściowych (o równych liczbach zębów), z czego wynika, że mechanizm ten, jako przekładnia planetarna, ma przełożenie wewnętrzne iw = – 1. Z ogólnego równania opisującego właściwości kinematyczne przekładni planetarnych wynika, że dla oznaczeń zgodnych z rysunkiem 2, gdzie ωo jest prędkością kątową wejściową (obudowy), a ω1 i ω2 są prędkościami członów wyjściowych, spełniona jest zależność:

Wynika z niej, że prędkość kątowa ω0 jest zawsze równa wartości średniej arytmetycznej prędkości ω1 i ω2 wałów wyjściowych. Jest to bardzo korzystna cecha prostego mechanizmu różnicowego, zwłaszcza w przypadku jego stosowania w mostach napędowych, gdyż umożliwia pokonywanie zakrętów bez zmian prędkości obrotowej i obciążenia silnika napędowego.

W celu wykonania analizy rozdziału doprowadzonego momentu M0 na momenty wyjściowe M1 i M2, konieczne jest uwzględnienie, oprócz cech geometrycznych przekładni zębatej, także występującego momentu tarcia wewnętrznego (lub ogólnie – momentu oporu wewnętrznego). Gdyby pominąć moment tarcia wewnętrznego to w symetrycznym mechanizmie różnicowym momenty na obydwu wałach wyjściowych będą zawsze równe. Z fizycznej analizy pracy mechanizmu z tarciem wewnętrznym wynika, że przy różnicowaniu prędkości obrotowych na wale wyjściowym wolniej obracającym się będzie występował większy moment obrotowy (tarcie wspomaga napędzanie wału), a na wale szybszym mniejszy (tarcie hamuje ten wał). Znajduje to odbicie w opisach dynamiki przedstawianych w literaturze (na przykład [14]), gdzie zamiast oznaczeń momentów obrotowych M1 i M2 przyjmuje się umowne oznaczenia Mprzysp – moment obrotowy na wale przyspieszanym i Mopóźn – moment obrotowy na wale opóźnianym. Wówczas równanie momentów dla mechanizmu różnicowego ma postać:

Wszystkie cząstkowe wewnętrzne momenty tarcia, występujące pomiędzy poszczególnymi elementami mechanizmu, zastępuje się jednym ogólnym momentem tarcia wewnętrznego MT, który obecnie najczęściej określa się według tak zwanej definicji amerykańskiej [14]. Zgodnie z nią, dla symetrycznego mechanizmu różnicowego jest on równy różnicy momentów obrotowych na wałach wyjściowych potrzebnej do uruchomienia mechanizmu, czyli obrócenia jednego wału względem drugiego.

Z zależności 2 i 3 otrzymuje się równania określające wartości momentów wyjściowych Mopóźn i Mprzysp jako wynik rozdziału momentu wejściowego M0 z uwzględnieniem tarcia wewnętrznego:

Powyższe równania są słuszne w warunkach tarcia rozwiniętego, a więc wtedy, gdy występuje ruch względny elementów mechanizmu różnicowego. Jak długo różnica pomiędzy stycznymi reakcjami nawierzchni działającymi na koła napędowe jest zbyt mała, aby pokonać moment tarcia wewnętrznego i wywołać ruch mechanizmu różnicowego, tak długo obydwa koła będą miały jednakową prędkość kątową ω1=ω2. Jednak w tej sytuacji momenty obrotowe nie muszą być równe, ale mogą się dowolnie wahać w granicach od wartości minimalnej (0,5 M0 – 0,5 MT) do wartości maksymalnej (0,5 M0 + 0,5 MT), a zakres wartości pomiędzy tymi granicami nazywa się obszarem nieczułości mechanizmu różnicowego. Tak więc z faktu, że równe są prędkości kątowe wałów wyjściowych ω1=ω2 (również przy stosowaniu blokad sprzęgłami kształtowymi) nie wynika równość momentów wyjściowych, co jest częstym błędem w rozumieniu działania mechanizmów różnicowych.

Gdyby udało się zbudować mechanizm różnicowy o momencie tarcia wewnętrznego MT = 0, to jak już zostało wspomniane, oraz zgodnie z wzorami 4, rozdzielałby on doprowadzony moment M0 równo na dwa wały wyjściowe:

Mechanizm taki można by nazwać teoretycznym. Na pewno nie należy go nazywać idealnym, gdyż pod względem właściwości napędowych, w wielu sytuacjach, byłby niekorzystny. Jak już było wspomniane, chodzi o przypadki, kiedy mała siła przyczepności jednego z kół napędowych ogranicza wykorzystanie siły przyczepności drugiego koła. Wówczas sumaryczna siła napędowa kół mostu jest mniejsza od sumy sił przyczepności obu kół. Wada ta jest powszechnie znana i dotyczy wszystkich pojazdów wyposażonych w proste mechanizmy różnicowe, w którym tarcie wewnętrzne jest małe i ich właściwości napędowe są zbliżone do mechanizmu różnicowego teoretycznego.

Z zależności opisującej rozdział momentów (4) wynika pewne ograniczenie w działaniu mechanizmów o powiększonym tarciu wewnętrznym. Ograniczenie polega na tym, że zwiększenie momentu obrotowego jest możliwe tylko na wale (kole) wolniejszym, a zmniejszenie tylko na wale (kole) szybszym. Jest to znacząca niedoskonałość tej metody korygowania rozdziału momentów obrotowych, gdyż w wielu sytuacjach ruchu samochodu korzystny byłby odwrotny rozdział. Dopiero najnowsze rozwiązania, tak zwane aktywne mechanizmy różnicowe, pozbawione są tej cechy, jednak z racji dużej ich złożoności i kosztów są stosowane bardzo rzadko ([1],[3],[8],[10],[11]). Dlatego, z powodu względnej prostoty konstrukcji, powiększanie tarcia wewnętrznego w mechanizmie różnicowym jest ciągle jednym z głównych sposobów poprawiania jego właściwości napędowych. Warto również dodać, że w niektórych przypadkach zamiast terminu tarcie wewnętrzne używa się określenia opór wewnętrzny. Jest to szczególnie uzasadnione w przypadku konstrukcji ze sprzęgłami hydraulicznymi, w których moment tego oporu zależy od różnicy prędkości kątowych. W takich rozwiązaniach wzory 1, 2, 3 i 4 zachowują swoją ważność, ale pojęcie „obszar nieczułości” traci swój sens.

Przedstawioną analizę można rozwinąć i objąć nią również niesymetryczne mechanizmy różnicowe, a więc takie, w których koła koronowe mają różne ilości zębów. Z działania takich przekładni planetarnych wynika rozdzielanie wyjściowych momentów obrotowych w stałych proporcjach, które dodatkowo mogą być zmieniane przez wprowadzanie momentu tarcia wewnętrznego. Szersze analizy takich mechanizmów zostały opisane w literaturze (między innymi [10], [14]).

Przedstawiona analiza kinematyki i dynamiki nie obejmuje wszystkich możliwych wariantów mechanizmów różnicowych. Wspomniane już tak zwane aktywne mechanizmy różnicowe (systemy Torque Vectoring) (tab. 1, grupa II e) wymagają odrębnej analizy.

Należy jeszcze dodać, że w przypadku mechanizmów różnicowych o powiększonym tarciu wewnętrznym, bardzo duży wpływ na końcowy efekt ich działania ma charakterystyka generowanego momentu tarcia, czyli – w zależności od jakich parametrów i w jaki sposób zmienia się jego wartość. Opisane dalej mechanizmy tego typu będą się różniły głównie układem konstrukcyjnym i charakterystyką generowanego momentu tarcia.

Rodzaje mechanizmów różnicowych i wybór obszaru prac badawczych

W wyniku kilkudziesięciu lat rozwoju powstała duża ilości typów i odmian mechanizmów różnicowych. Na rysunku 3 przedstawiona jest moja próba ich zestawienia i klasyfikacji [10].

Rys. 3 Rodzaje mechanizmów różnicowych

i systemów rozdziału mocy

zawierających mechanizmy różnicowe

W zestawieniu tym również umieściliśmy złożone systemy rozdziału mocy, w których mechanizmy różnicowe są tylko zespołami składowymi obok indywidualnie sterowanych hamulców kół lub dodatkowych przekładni zębatych i sprzęgieł sterujących.

Przyjęte w klasyfikacji kryteria podziału, to jest sposób i jakość realizowania rozdziału momentów obrotowych, nie są jedynymi możliwymi, ale bardzo istotnymi z punktu widzenia cech funkcjonalnych i przyjętego kierunku przedstawionych dalej prac badawczych.

Proste mechanizmy różnicowe (otwarte) ciągle są podstawowym standardem technicznym w pojazdach. Są one również wykorzystywane jako rozwiązania bazowe do tworzenia konstrukcji bardziej zaawansowanych. Mechanizmy różnicowe blokowane stanowią historycznie bardzo wczesne rozwiązania poprawiające zdolność napędową. Jednak z powodu sztywnego łączenia kół napędowych obecnie uważa się, że nie mogą one spełnić wysokich wymagań w zakresie stateczności i kierowalności pojazdów.

Mechanizmy różnicowe o powiększonym momencie oporu wewnętrznego współcześnie stanowią zaawansowaną i niezwykle rozbudowaną grupę rozwiązań. W konstrukcjach tych, poprzez ciągłe lub okresowe powiększanie momentu tarcia, uzyskuje się cechy pośrednie pomiędzy mechanizmem prostym, a zablokowanym. Historyczny rozwój tych mechanizmów przebiegał od konstrukcji o stałym momencie tarcia (opisanych w literaturze [4], [14], [16]), następnie o zależnym od przenoszonego momentu ([4], [9], [10], [14], [16], [18]), aż po rozwiązania o tarciu sterowanym parametrami kinematycznymi ruchu elementów mechanizmu ([5], [6], [9], [10], [14], [16], [17]) lub ruchu pojazdu ([2], [14]). Zwłaszcza te dwie ostatnie grupy mechanizmów wykazują wiele korzyści w eksploatacji, gdyż w większości warunków jazdy pracują jako proste mechanizmy różnicowe (otwarte), a moment tarcia rośnie w nich tylko krótkotrwale, w chwilach poślizgu kół napędzanych.

Można wyróżnić co najmniej dwa nurty realizacji mechanizmów różnicowych o powiększonym momencie tarcia. Pierwszy z nich obejmuje konstrukcje, w których mechanizm różnicowy i zespół generujący moment tarcia stanowią jeden zintegrowany zespół o konstrukcyjnie zadanej, niezmiennej charakterystyce działania. Do grupy takich rozwiązań należy zaliczyć mechanizmy różnicowe o momencie tarcia zależnym od przenoszonego momentu (np. typu Torsen [18]), ze sprzęgłami lepkościowymi i ciernymi z pompą hydrauliczną (np. typu Haldex [17]), jak również większość przedstawionych dalej własnych rozwiązań autora. Drugi nurt konstrukcyjny jest oparty o typowe układy i elementy współczesnej automatyki. Mechanizmy takie są wyposażone w dodatkowe sprzęgła cierne sterowane hydraulicznie lub elektrycznie przez zewnętrzny system zawierający moduł elektroniczny połączony z odpowiednimi czujnikami. Zaletą tych rozwiązań jest możliwość generowania różnych charakterystyk momentu tarcia, w zależności od wielu parametrów poruszającego się pojazdu. Układy takie są jednak bardziej złożone i stosunkowo drogie, ponadto wykazują pewną zwłokę w działaniu. Przykładowe konstrukcje tego typu to mechanizmy stosowane już w pierwszej generacji samochodów Mercedes 4 MATIC, czy mechanizmy różnicowe firmy GKN, np. oznaczone symbolem ECA (Electronic Clutch Activation). Podobne rozwiązania opracowało wiele firm, również autor, wraz ze specjalistami z Ośrodka Badawczo-Rozwojowego Samochodów Małolitrażowych BOSMAL, zaprojektował tego typu mechanizm różnicowy do tylnego mostu prototypowego małego samochodu osobowego z napędem typu 4x4.

Rysunek 3 obejmuje także dwie współcześnie ważne grupy rozwiązań układów napędowych wykorzystujących mechanizmy różnicowe. Pierwszą z nich są systemy, w których funkcje rozdziału momentów obrotowych realizują nie tylko zespoły układu napędowego, ale i współdziałający z nim układ hamulcowy. Systemy te występują zarówno w układach napędowych 4x2, jak i 4x4. W obu przypadkach stosuje się zwykle proste mechanizmy różnicowe, zaś współpracujący układ hamulcowy musi być odpowiednio rozbudowany tak, aby było możliwe indywidualne hamowanie każdego koła, z elektroniczną kontrolą tego procesu. Najczęściej systemy te oznaczone są symbolem ASR (Antriebs-Schlupf-Regelung) i oferowane w wielu modelach samochodów osobowych, ciężarowych

i autobusach, jako wyposażenie dodatkowe lub, coraz częściej, standardowe. Hamowanie ślizgającego się koła, dzięki działaniu prostego mechanizmu różnicowego, powoduje zwiększenie siły napędowej na drugim kole mostu, a w przypadku permanentnego układu napędowego typu 4x4 może zwiększyć siły napędowe nawet na trzech pozostałych kołach. W większości tych systemów, w przypadku ich aktywacji, równolegle stosuje się ograniczenie momentu obrotowego silnika. Główną zaletą systemów ASR jest uniknięcie rozbudowy układu mechanicznego i związanych z tym dużych kosztów. Niezbędne zmiany w układzie hamulcowym zwykle są niewielkie, gdyż system ten stanowi rozwinięcie istniejących już wcześniej w samochodach systemów zapobiegających blokowaniu kół przy hamowaniu (ABS). Jako wady wskazuje się opóźnienie w działaniu, zwiększone zużycie hamulców oraz pogorszoną sprawność przeniesienia napędu.

Drugą i najnowszą grupą rozwiązań są systemy z mechanizmami różnicowymi o dodatkowej więzi kinematycznej, często nazywane aktywnymi. Jak już wspomnieliśmy, przy analizie dynamiki mechanizmów różnicowych, w większości typów nie dają one możliwości doprowadzenie większego momentu obrotowego do koła o większej prędkości kątowej. Mechanizmy aktywne umożliwiają wyeliminowanie tej znaczącej wady i w efekcie zyskują nową ważną zaletę, jaką jest możliwość wpływania na kierunek jazdy. Spowodowało to powstanie w specjalistycznej literaturze takich określeń, jak Torque Vectoring i Vector Drive. W zespołach tych, oprócz prostego mechanizmu różnicowego, występują włączane sprzęgłami ciernymi boczne przekładnie zębate, okresowo narzucające określoną więź kinematyczną między obudową i wałami wyjściowymi (rys. 4).

Rys. 4 Przykładowy schemat aktywnego mechanizmu różnicowego (o dodatkowej więzi kinematycznej) – mechanizm różnicowy tylnego mostu samochodu BMW X6 [3]

Mechanizmy te mają bardzo złożoną budowę, jednak mimo tego, po okresie opracowań studialnych i zastosowań w sporcie samochodowym są coraz częściej oferowane w seryjnych samochodach osobowych, ale najwyższej klasy. Aktywne mechanizmy różnicowe muszą być sterowane przez układ elektroniczny wykorzystujący informacje z wielu czujników określających parametry ruchu pojazdu i zachowanie kierowcy.

W następnych częściach będą przedstawione własne prace badawcze, które skoncentrowane były na opracowaniu nowych typów mechanizmów różnicowych o powiększonym momencie oporu wewnętrznego. Kierując tymi pracami przyjąłem założenie, że możliwości rozwiązań mechanicznych w zakresie sterowania takimi mechanizmami nie do końca zostały wykorzystane i celowe są dalsze poszukiwania nowych koncepcji, które umożliwią zbudowanie mechanizmów o innych zasadach działania i lepszych charakterystykach pracy.

dr hab. inż. Jan Dzida

Literatura:

- Avenatti R., Campo S., Mesiti D.: An Active Differential to Enhance Vehicle Dynamic Stability. ATA International Conference, Active and Passive Automobile Safety, Capri, 1997.

- Danisch R.: Das Antriebsregelsystem Q2 von Alfa Romeo. Automobiltechnische Zeitschrift, nr 6, 2007.

- Denzler R., Granzow C., Peter R., Spiess M.: Das Hinterachsgtriebe Vector Drive. Automobiltechnische Zeitschrift, nr 12, 2007.

- Dębicki M.: Teoria samochodu – teoria napędu. WNT, Warszawa, 1971.

- Dzida J.: Durch Kinematische Einflußgroßen gesteuertes Differentialgetriebe mit Eigenreibung. Automobiltechnische Zeitschrift, nr 4, 1990.

- Dzida J.: Differentiale con atritto interno controlato da grandezze cinematiche. Organi di Transmissione, nr 12, 1991.

- Dzida J.: Koncepcja konstrukcji członów wykonawczych do układów automatycznego sterowania zespołami samochodu. VII Międzynarodowe Sympozjum IPM WAT nt. Doskonalenie konstrukcji oraz metod eksploatacji pojazdów mechanicznych, Warszawa-Rynia, 1999.

- Dzida J., Mesiti D.: Aktywny mechanizm różnicowy – nowa jakość w sterowaniu pojazdów. Zeszyty Naukowe OBR SM Bosmal, nr 21/I-II, Bielsko-Biała, 2003.

- Dzida J.: Mechanizmy różnicowe sterowane regulatorami mechanicznymi reagującymi na parametry kinematyczne. Archiwum Motoryzacji, nr 3, 2007.

- Dzida J.: Mechanizmy rozdziału mocy w pojazdach. Rozprawa habilitacyjna. Wydawnictwo Akademii Techniczno-Humanistycznej, Bielsko-Biała, 2010.

- Freimann R., Wolter T-M., Schneider E.: Driving dynamics and hybrid combined in the torque vectoring – Concepts of axle differetials with hybrid functionality and active torque distribution. Vehicle Dynamics Expo 2009, Stuttgart, 2009.

- Gajek A., Juda Z.: Mechatronika samochodowa – Czujniki. WKŁ, Warszawa, 2008.

- Herner A., Riehl H.: Elektrotechnika i elektronika w pojazdach samochodowych. WKŁ, Warszawa, 2009.

- Jaśkiewicz Z.: Mosty napędowe. WKŁ, Warszawa 1977.

- Lanzendorfer J., Szczepaniak C.: Teoria ruchu samochodu. WKŁ, Warszawa 1980.

- Madej J.: Mechanika transmisji momentu trakcyjnego. Oficyna Wydawnicza Politechniki Warszawskiej, Warszawa, 2000.

- Reimpell J., Betzler J. W.: Podwozia samochodów. Podstawy konstrukcji. WKŁ, Warszawa, 2001.

- Sacchetini P.: The Torsen Differentials. Vehicle Dynamics Expo 2006, Stuttgart, 2006.

artykuł pochodzi z wydania Lipiec/sierpień 7 (58) 2012

Rozwiązywanie równań różniczkowych cząstkowych wymaga znajomości zaawansowanego aparatu matematycznego. Dla prostych przypadków jesteśmy w stanie uzyskać rozwiązanie analityczne, dla przypadków złożonych najczęściej jest to niemożliwe. Jedną z metod numerycznego rozwiązywania równań cząstkowych jest metoda objętości skończonych, która polega na podziale analizowanego obszaru na małe elementy kontrolne i przeprowadzenia po nich całkowania. Kształt elementu kontrolnego może być dowolny, co jest jedną z przyczyn dużej popularności tej metody, zwłaszcza do rozwiązywania równań mechaniki płynów.

Adam Piechna

W niniejszym artykule zastosujemy metody objętości skończonych do zamodelowania dwóch zagadnień: przewodzenia ciepła w pręcie i rozkładu ciśnień w szczelinie pomiędzy pierścieniem tłokowym a ścianą cylindra.

Wykorzystanie metody objętości skończonych przedstawimy na przykładzie równania dyfuzji. Ogólna postać równania jest następująca:

gdzie :

Φ – zmienna, której rozkładu szukamy

Γ – współczynnik dyfuzji; w ogólnym przypadku może być zależny od x

S – człony źródłowe

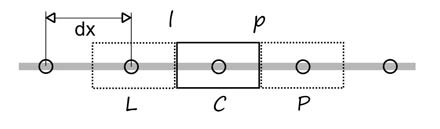

Ideą metody objętości skończonych jest podział analizowanego obszaru na skończenie małe objętości tzw. objętości kontrolne i przeprowadzenie po nich całkowania. Schematyczny podział obiektu jednowymiarowego przedstawiono na rysunku 1.

Rys. 1 Dyskretyzacja (podział) obiektu 1D na objętości kontrolne. Analizowana objętość kontrolna ma środek w punkcie C. Indeksami L i P oznaczono kolejno: lewą komórkę i prawą komórkę. Indeksami l i p oznaczono powierzchnie pomiędzy komórką centralną, a komórkami po lewej i prawej stronie.

Po dokonaniu podziału interesującego nas obszaru możemy wykonać całkowanie po wydzielonych objętościach:

Stosując twierdzenie Ostrogradskiego-Gaussa możemy zamienić całki objętościowe na całki powierzchniowe. W najprostszym przypadku 1D, stosując oznaczenia jak na rysunku 1 otrzymamy:

Przyjmując Γ = const., A = const., dx = const. (W ogólnym przypadku Γ , A, dx mogą być funkcją x) oraz zamieniając różniczkę na różnicę otrzymamy:

Podstawiając otrzymujemy:

Porządkując otrzymujemy:

Jest to równanie algebraiczne liniowe opisujące zależności pomiędzy trzema elementami. Dzieląc analizowany obszar na przykład na pięć elementów musimy sformułować układ równań składający się z pięciu równań – po jednym dla każdego elementu kontrolnego. Równania dla elementu pierwszego i ostatniego będą różnić się od pozostałych. Elementy te są elementami brzegowymi i konieczne jest zdefiniowanie tzw. warunku brzegowego. Dwa typowe warunki to tzw. warunek Dirichlet’a (wartość zmiennej na brzegu) i Neumann’a (wartość pochodnej na brzegu). Rozpisując równania dla przykładu pięciu elementów otrzymamy układ równań :

W postaci macierzowej :

Równania w takiej postaci są bardzo proste do rozwiązania np. korzystając ze środowisk obliczeniowych GNU Octave (darmowe) lub Matlab.

Analiza rozkładu temperatury w pręcie

Stosując przedstawioną metodykę rozwiążemy zagadnienie: Obliczyć rozkład temperatury w aluminiowym pręcie. Pręt zanurzony jest w przepływającej wodzie o temperaturze 300 K. Oba końce pręta stykają się z płytą o temperaturze 500 K.

Rys. 2 Analizowany przypadek: rozkład temperatury w pręcie zanurzonym w płynącej wodzie

Pręt oddaje ciepło do powietrza i wody zgodnie z zależnością:![]()

Równanie opisujące niniejsze zagadnienie, po uwzględnieniu członu źródłowego ma postać:

Współczynnik przewodzenia dla aluminium wynosi: k = 250 [W/K/m].